引言

人工智能(AI)技术在过去十年中经历了前所未有的发展,从学术研究走向广泛的商业应用。这一快速发展不仅带来了令人瞩目的技术突破,也催生了复杂多样的软硬件生态系统。在这个快速演进的领域中,理解和掌握AI技术栈的结构和特点变得越来越重要。

本文旨在提供一个系统化的视角来审视当前AI技术栈的构成。我们将深入探讨从底层硬件到高层应用框架的各个层次,分析它们之间的相互关系,以及如何协同工作以支持现代AI系统的开发和部署。通过这种分层的方法,我们不仅可以更好地理解现有技术,还能洞察未来的发展趋势。

在接下来的章节中,我们将首先概述AI技术栈的整体架构,然后逐一深入探讨各大主流平台(如NVIDIA、AMD、Intel等)的技术特点。我们将分析每个平台在各个层次的实现,比较它们的优势和局限性,并探讨如何在实际应用中做出最优的技术选择。

通过本文,我们希望为AI研究者、开发者和决策者提供一个全面的参考框架,帮助他们在这个快速发展的领域中做出明智的技术决策,并为未来的创新铺平道路。

技术栈架构概述

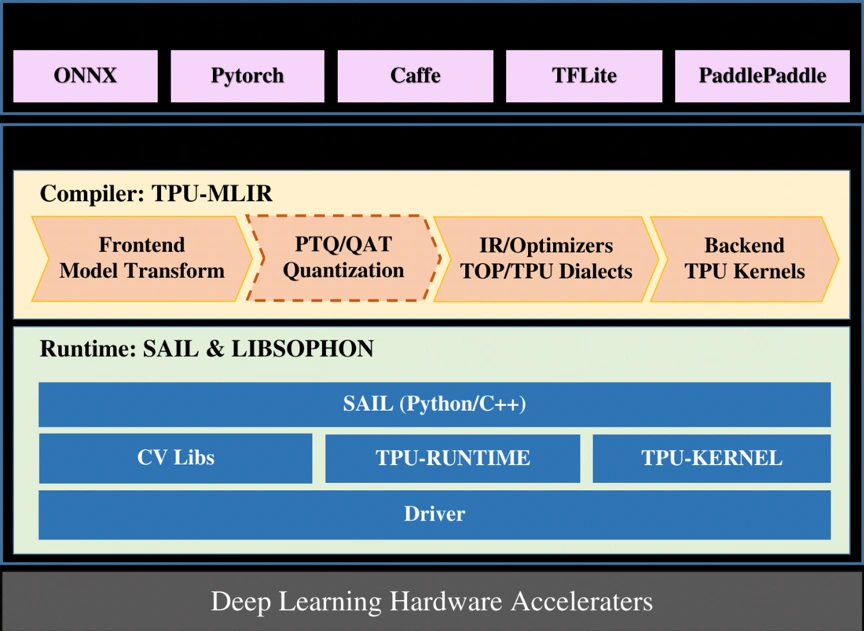

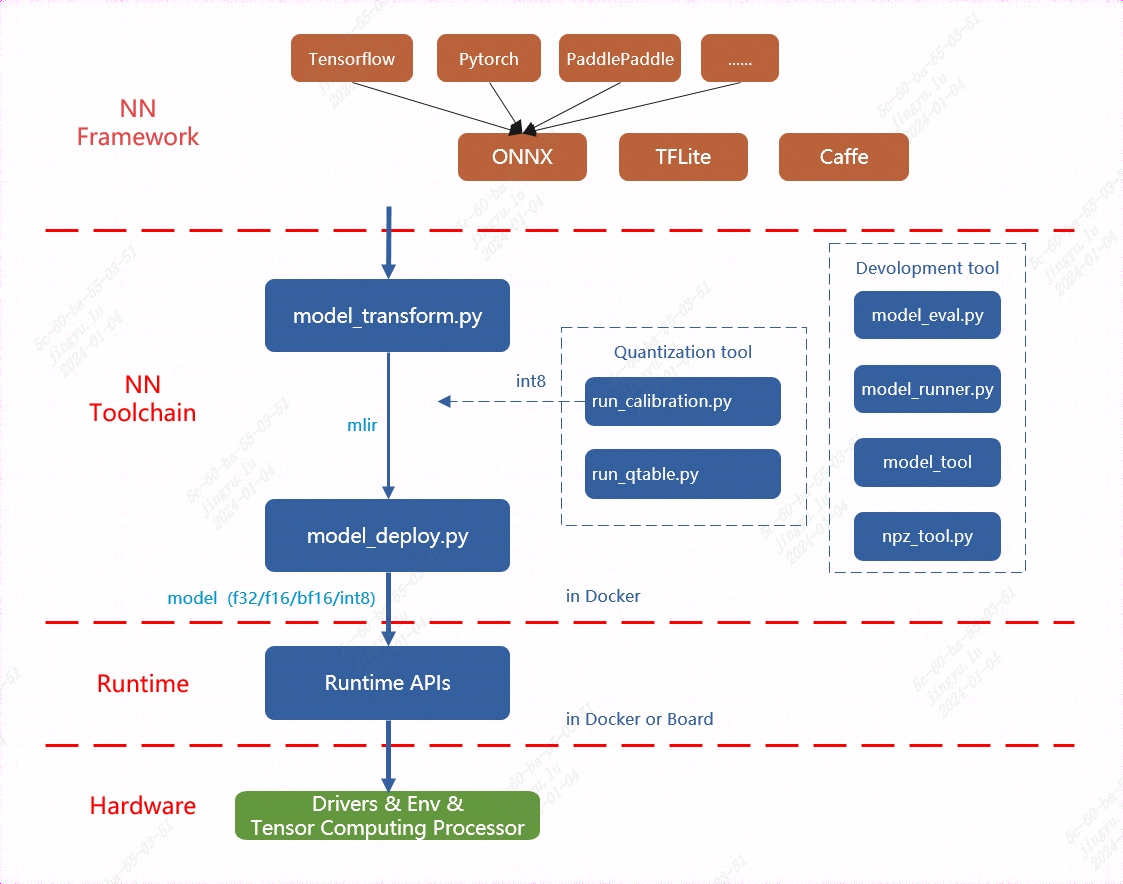

在本节中,AI技术栈层次提出了一种新的分层方法,将AI技术栈分为系统软件层、运行时环境层、编程模型和语言层、计算库层以及框架模型层。这种结构不仅有助于理清各种技术之间的关系,还为开发者和研究者提供了一个系统化的视角。

其次,AI技术栈的意义探讨了这种分层方法所带来的多重优势,如实现系统化理解、促进模块化设计、精确定位性能瓶颈以及推动技术标准化等。这使得不同层次的技术能够更有效地比较与优化,为选择适合的技术方案提供了坚实依据。

最后,AI技术栈分层方法与应用详细阐述了每一层的具体执行和应用实例,包括对API调用和硬件接口的分析、编程语言的特性比较以及计算库和框架性能的评估。通过这种全面的分层分析,我们不仅能够更好地理解当前AI系统的性能特征,还为未来的技术发展与优化提供了清晰的路径。

AI 技术栈层次

人工智能技术的快速发展带来了复杂多样的软硬件生态系统。为了更好地理解和利用这些技术,我们提出了一种新的分层方法来分析AI技术栈。这种分层不仅有助于我们理清各种技术之间的关系,还为开发者、研究者和决策者提供了一个系统化的视角来审视整个AI生态系统。

AI 技术栈通常包含以下层次:

- 系统软件层:设备驱动程序、底层 API

- 运行时环境层:执行环境和运行时库

- 编程模型和语言层:特定于硬件的编程语言和模型

- 计算库层:优化的数学和深度学习库

- 框架模型层:高级深度学习框架

系统软件层是整个技术栈的基础,它直接与硬件交互,提供底层的驱动程序和API。这一层的设计和优化直接影响了整个系统的性能和稳定性。运行时环境层则在系统软件之上提供了一个抽象层,使得上层应用能够更加高效地利用硬件资源。

编程模型和语言层是开发者与系统交互的主要接口。不同的编程模型和语言反映了不同的计算范式和抽象级别,从而影响了开发效率和代码可移植性。计算库层提供了高度优化的数学和机器学习算法实现,是提升性能的关键所在。最上层的框架模型层则为开发者提供了高级的API和工具,大大简化了AI模型的开发和部署过程。

AI技术栈的的意义

AI技术栈的分层方法不仅仅是一种理论构造,它在实际应用和研究中具有深远的意义和多方面的优势:

-

系统化理解:分层结构提供了一个系统化的框架,使得复杂的AI生态系统变得更加清晰可理解。这种结构化的视角有助于开发者、研究者和决策者更好地把握整个技术领域的全貌。

-

模块化设计:分层架构促进了模块化设计的思想。每一层都有明确定义的接口和功能,这使得开发者可以专注于特定层次的优化,而不必过多考虑其他层次的复杂性。

-

技术对比:通过分层,我们可以在相同的层次上比较不同平台或技术的实现。这种横向对比有助于识别各种技术的优势和劣势,为技术选型提供客观依据。

-

性能优化:分层结构使得性能瓶颈的定位变得更加精确。开发者可以针对特定层次进行优化,而不是盲目地对整个系统进行调整。

-

跨层优化:虽然分层提供了清晰的结构,但它也为跨层优化提供了可能。了解各层之间的相互作用,可以实现更深层次的系统优化。

-

标准化促进:分层架构为制定行业标准提供了基础。不同层次的标准化有助于提高技术的互操作性和可移植性。

总的来说AI技术栈提供了一个清晰的结构来理解和比较不同的AI技术。例如,当我们比较NVIDIA的CUDA和AMD的ROCm时,我们可以在每一层级进行对比,从而全面地评估两种技术的异同。这不仅有助于技术选型,还为性能优化提供了指导。

从开发者的角度来看,这种分层结构使得他们可以根据自己的需求和专长选择合适的切入点。例如,深度学习研究者可能主要关注框架模型层,而系统优化专家则可能更多地工作在底层。同时,这种分层也有利于跨层优化,开发者可以根据需要在不同层次间进行调优。

从行业发展的角度来看,这种分层结构也反映了AI技术的发展趋势。我们看到,在每一层都有不断涌现的新技术,如编程模型层的SYCL,计算库层的oneDNN,以及框架模型层的各种新兴深度学习框架。这种分层结构有助于我们更好地理解这些新技术在整个生态系统中的位置和作用。

通过这种分层方法,我们不仅能更好地理解和利用现有技术,还能为未来的技术发展提供清晰的路径和方向。

AI技术栈分层方法与应用

AI 技术栈的每个层次分析都有其特定方法和应用demo。本节将阐述后续章节的分析逻辑,解释为什么要进行这样的分层分析,以及每层分析的意义和应用。通过深入理解每个层次的特点,我们可以更好地利用 AI 技术栈来开发和优化 AI 系统。

2.3.1 系统软件层和运行时环境层

在后续章节中,这一层的分析主要聚焦于 API 调用和硬件接口,目的是理解不同技术路线在相同硬件平台下如何与底层系统交互。

-

API 调用分析

- 目的:了解各种 AI 框架和库如何与底层硬件交互

- 意义:揭示谁实际使用了 CUDA Driver API,CUDA Runtime API等底层接口,有助于理解不同技术路线调用相同接口的异同。

-

硬件接口比较

- 目的:比较不同 AI 技术栈在访问相同硬件时的方式

- 意义:了解不同方案的底层实现差异,为性能优化提供思路

-

扩展性分析

- 目的:研究如何为新硬件或新接口扩展现有系统

- 意义:为未来硬件适配和系统升级提供指导

这一层不进行直接的性能比较,因为系统软件层的差异通常不是性能瓶颈的主要来源。相反,我们关注的是不同方案如何利用底层资源,这为理解整体性能提供了基础。

2.3.2 编程模型和语言层

这一层的分析主要起到教学和概念引入的作用,为后续的深入分析奠定基础。

-

语言特性对比

- 目的:展示不同编程语言(如 Python、C++、CUDA)在 AI 开发中的应用

- 意义:帮助理解语言选择对开发效率和性能的影响

-

算子编写示例

- 目的:提供常见 AI 算子(如卷积、矩阵乘法)的实现示例

- 意义:深入理解算子工作原理,为后续优化提供思路

-

并行计算模型介绍

- 目的:解释 CUDA、OpenCL 等并行计算模型的基本概念

- 意义:为理解 GPU 加速原理和优化方法打下基础

这一层的分析不直接进行性能比较,而是为读者提供必要的背景知识,使他们能够理解后续章节中更复杂的性能分析和优化策略。

2.3.3 计算库层、框架模型层

在这些高层次中,我们将基于现有的 AI Benchmark进行更深入的应用和研究。

-

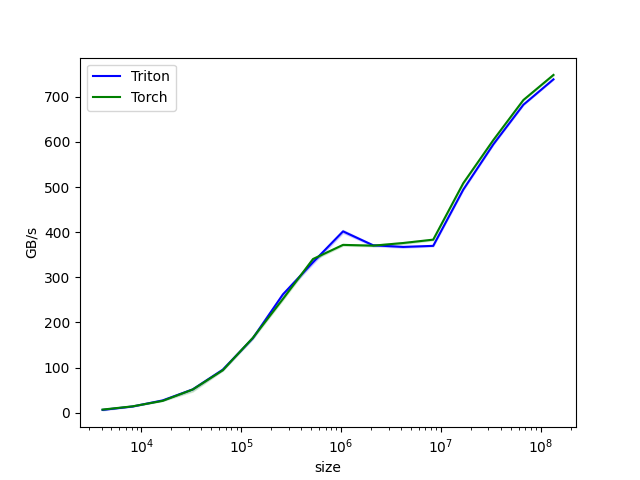

计算库性能分析

- 目的:比较不同计算库(如 cuDNN、oneDNN)在常见算子上的性能

- 意义:了解底层库对整体性能的影响,指导算子优化和选择

-

框架性能对比

- 目的:评估不同深度学习框架(如 TensorFlow、PyTorch)在相同任务上的性能

- 意义:帮助开发者选择适合特定任务的框架,了解框架优化的重要性

-

模型层 Benchmark 扩展

- 目的:将更多类型的模型纳入 AI Benchmark

- 意义:提供更全面的性能评估,覆盖更广泛的应用场景

-

算子级 Benchmark

- 目的:开发针对单个算子的性能测试套件

- 意义:深入了解性能瓶颈,指导底层优化

-

安装和部署指南

- 目的:基于 Benchmark 结果,提供模型选择和部署的最佳实践

- 意义:帮助用户根据自身硬件和需求选择最合适的模型和框架

这些高层次的分析直接关系到 AI 系统的最终性能。通过全面的 Benchmark 和分析,我们可以获得不同组件和配置的详细性能数据,从而指导实际应用中的选择和优化。

通过这种分层分析方法,我们可以全面地理解 AI 技术栈的各个层次,从底层硬件接口到高层模型性能。这种方法不仅有助于理解当前 AI 系统的性能特征,还为未来的优化和创新提供了清晰的路径。在后续章节中,我们将基于这个框架,提供具体的示例和深入分析,展示如何在实际应用中利用这种分层思想来优化 AI 系统性能。

NVIDIA 平台

NVIDIA 是一家领先的图形处理器(GPU)制造商,在人工智能(AI)领域拥有广泛的技术布局。NVIDIA 的 GPU 在深度学习、机器学习等 AI 应用中发挥着关键作用,为开发者提供了强大的硬件加速能力。

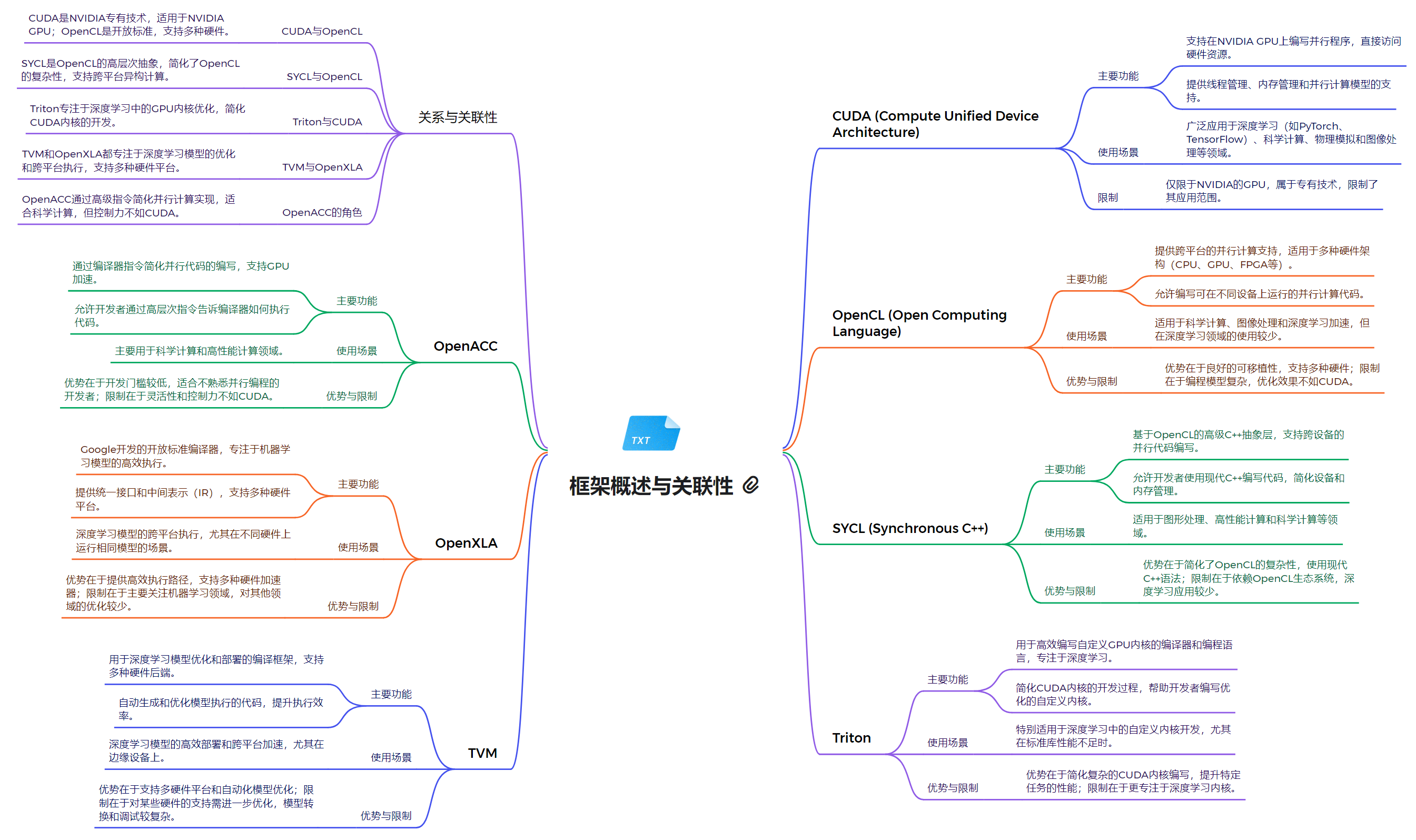

除了硬件,NVIDIA 平台还具备了一系列软件工具和框架,帮助开发者更好地利用 GPU 进行 AI 开发。接下来我们将介绍以下几个重要的 NVIDIA 平台相关技术并在后续通过AI技术栈进行深入分析:

CUDA

CUDA 是 NVIDIA 开发的一种通用并行计算架构,可以利用 NVIDIA GPU 进行高性能计算。CUDA 提供了一个编程模型和指令集,使开发者能够编写高效的并行程序,充分发挥 GPU 的计算能力。

OpenCL

OpenCL 是一种开放标准的并行计算框架,可以在异构计算平台(如 CPU、GPU、FPGA 等)上运行。与 CUDA 类似,OpenCL 也为开发者提供了编程模型和指令集,用于开发并行应用程序。

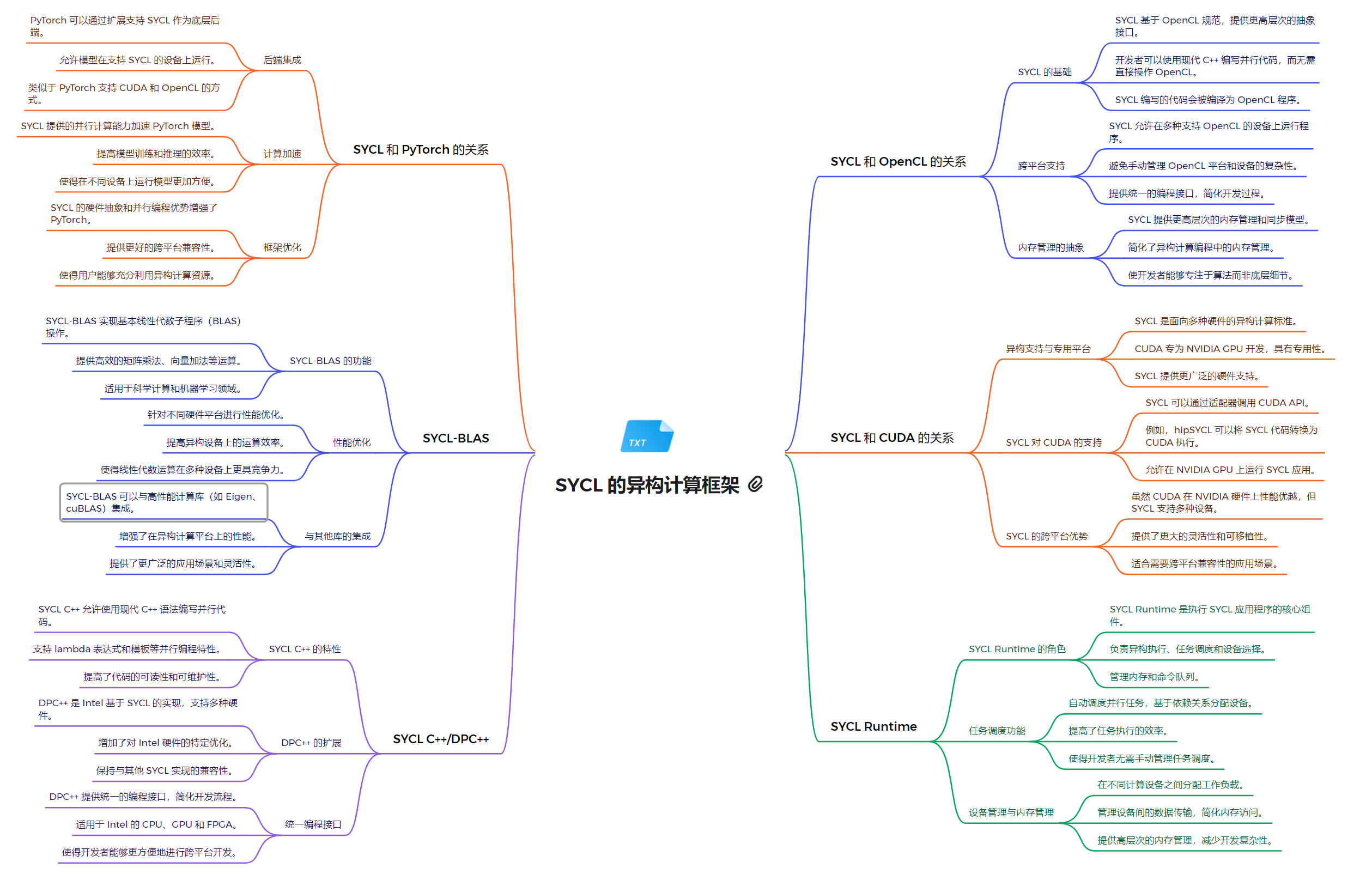

SYCL (DPC++)

SYCL 是基于 OpenCL 的一种C++层次化的异构编程模型。DPC++ 是 SYCL 的一种实现,由 Intel 开发并贡献给 LLVM 社区。DPC++ 支持在 CPU、GPU 和其他加速器上运行并行计算任务。

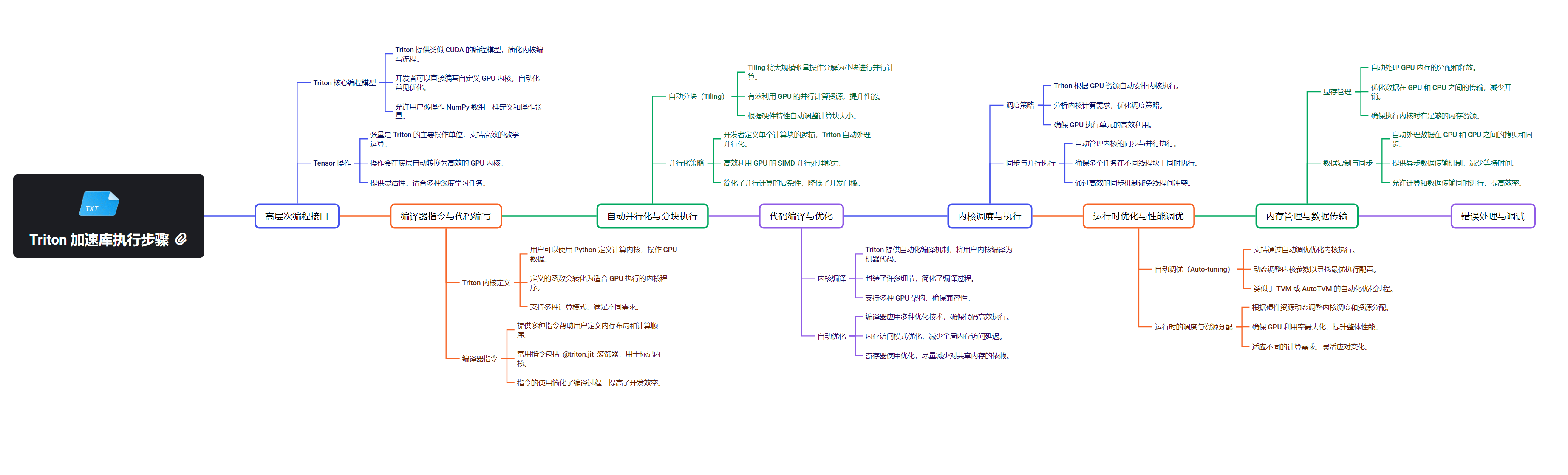

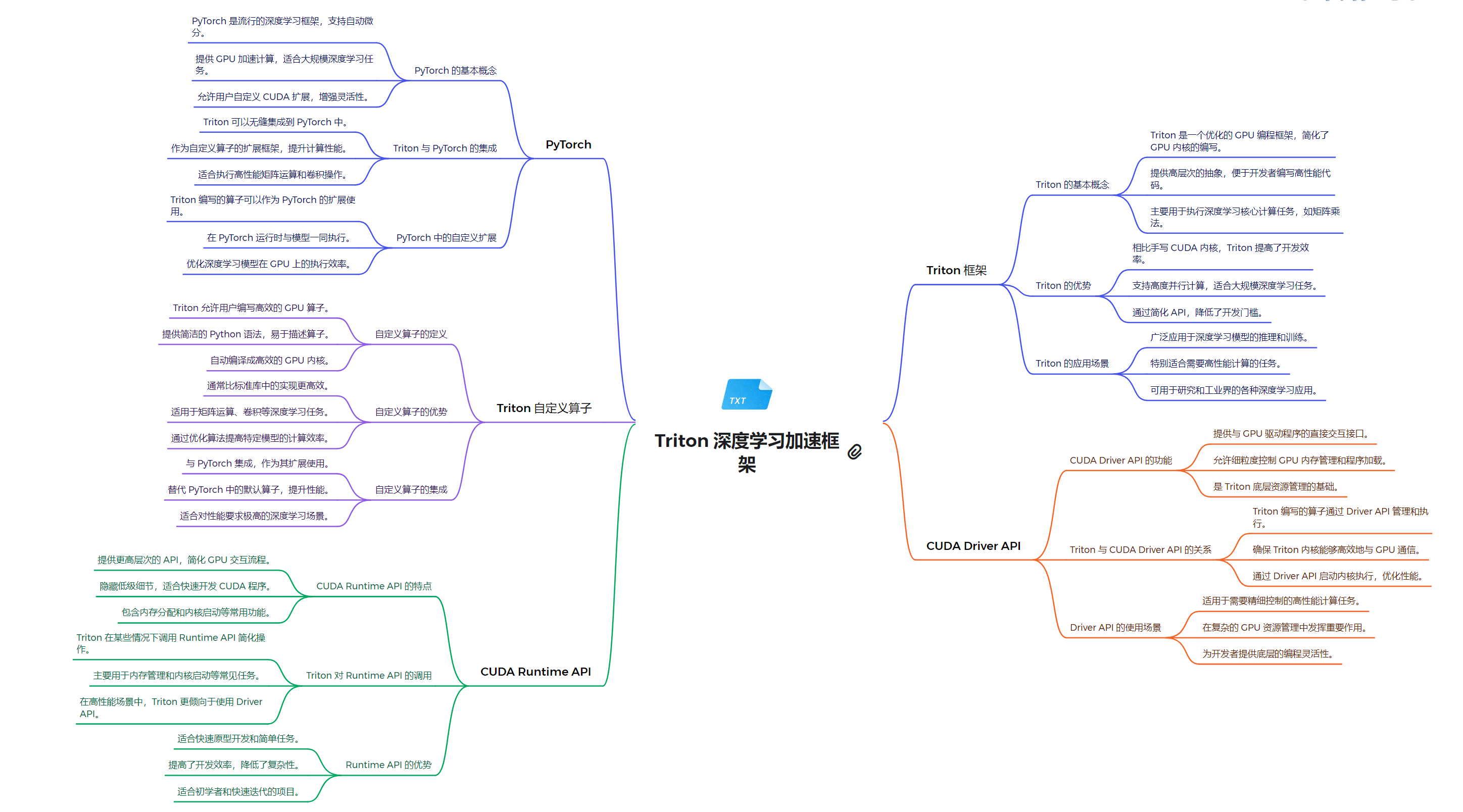

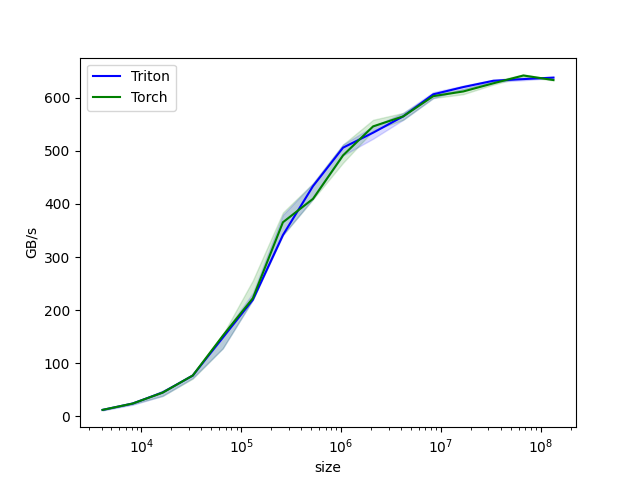

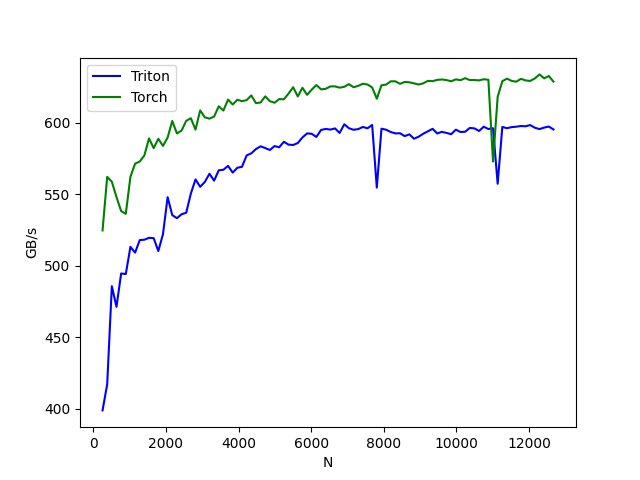

Triton

Triton 是 NVIDIA 开发的一个高性能推理服务器,可以部署和运行各种深度学习模型。Triton 支持多种框架(TensorFlow、PyTorch 等)和部署环境,为开发者提供了灵活的模型部署解决方案。

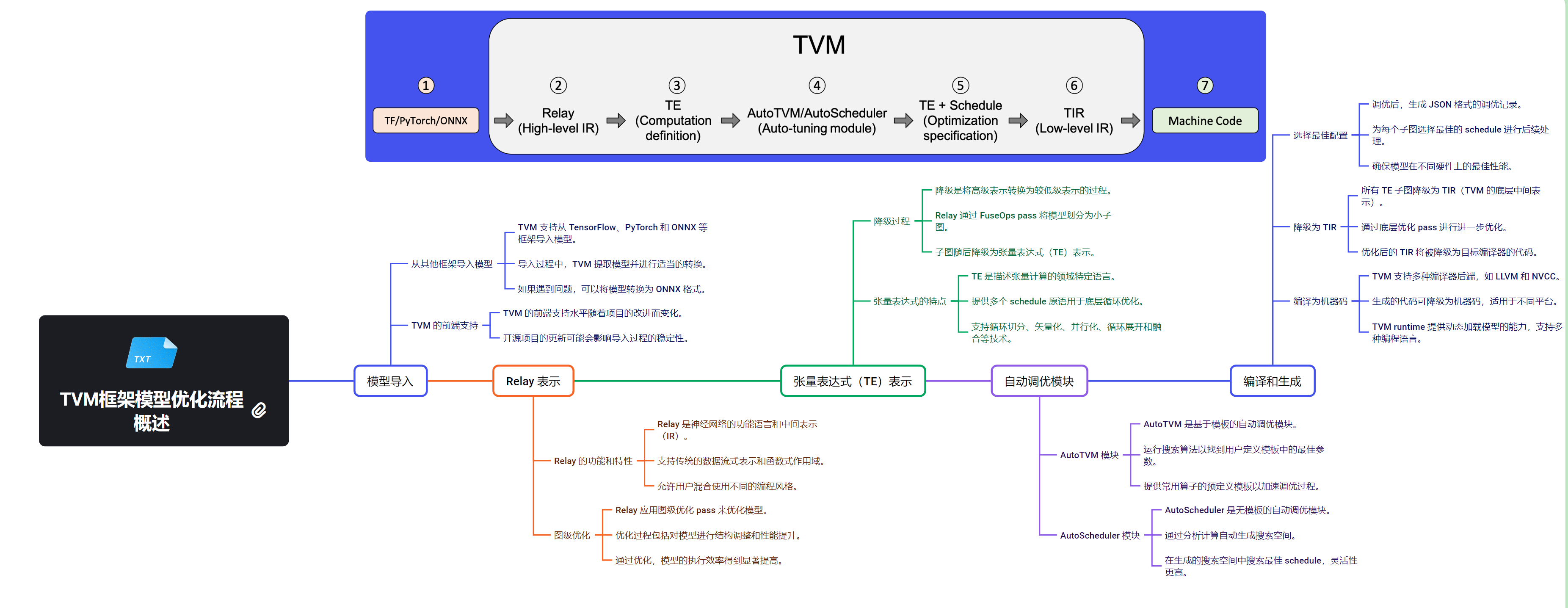

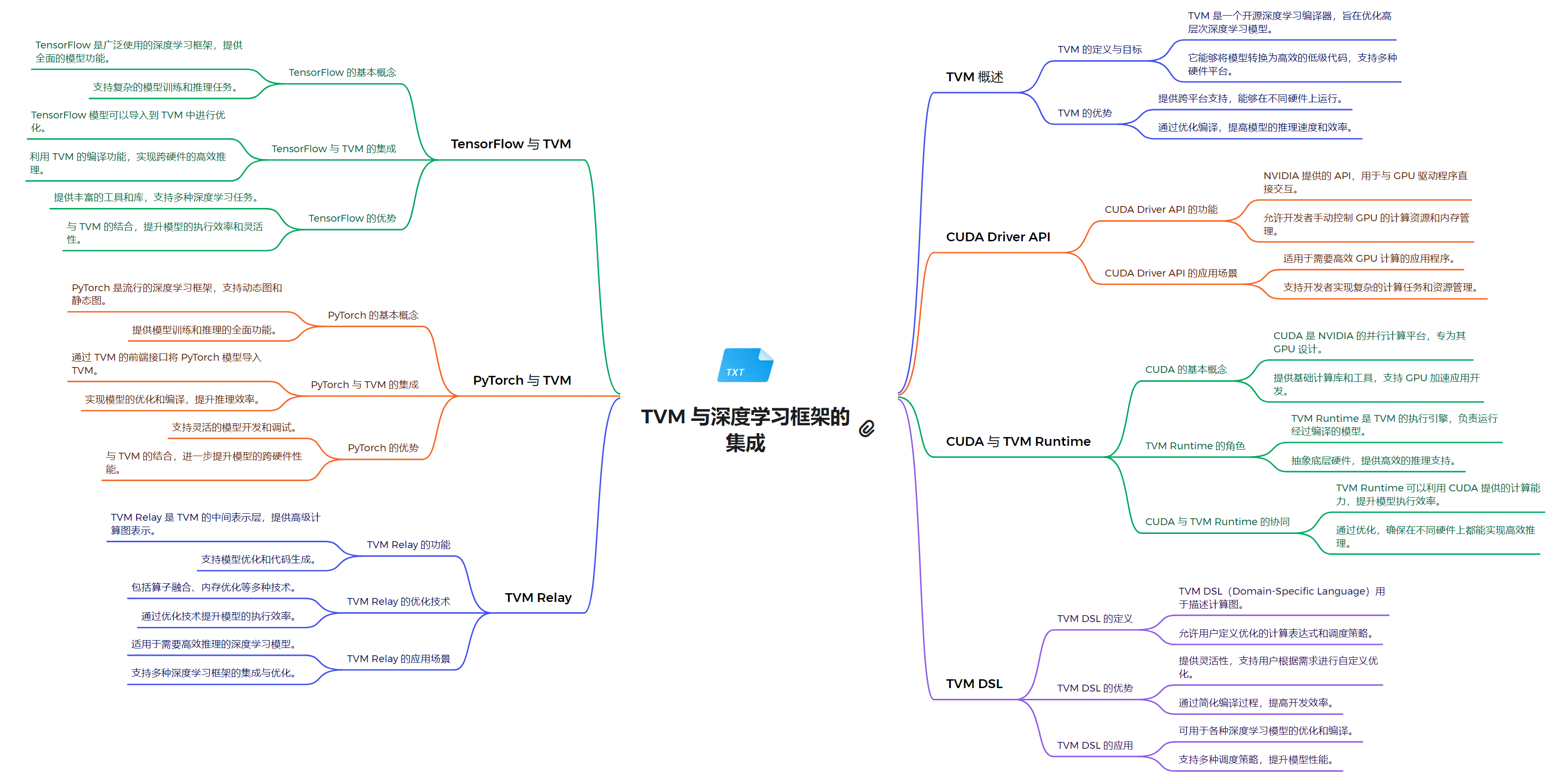

Apache TVM

Apache TVM 是一个开源的端到端机器学习编译器栈,可以针对不同的硬件平台(CPU、GPU、FPGA 等)优化机器学习模型的性能。TVM 可以与 NVIDIA 的 CUDA 和 Triton 等技术集成使用。

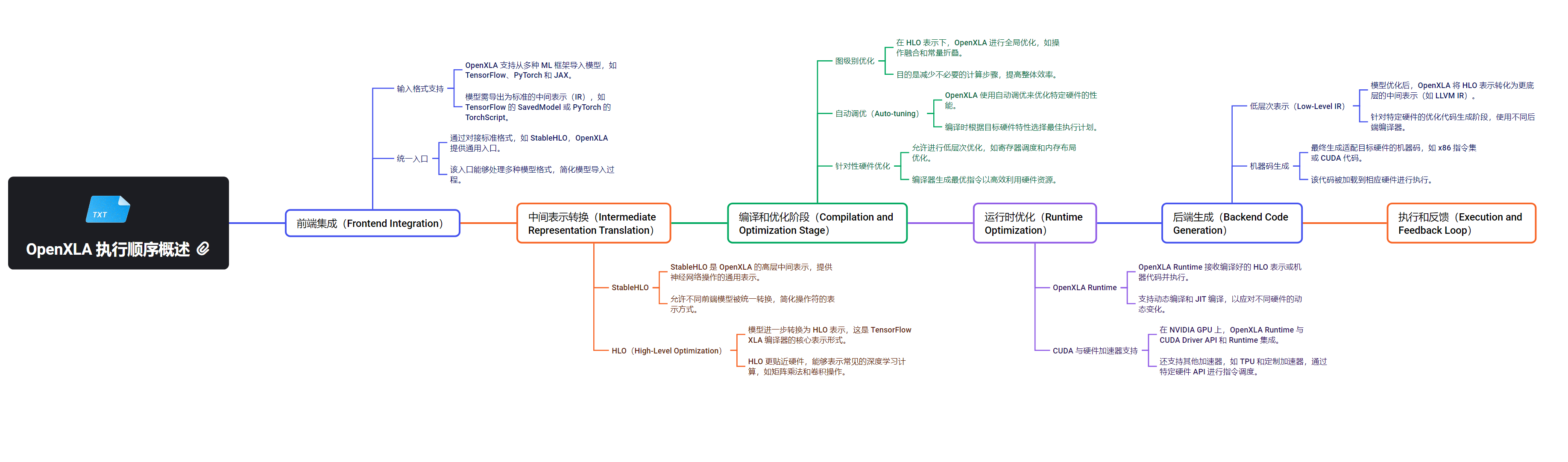

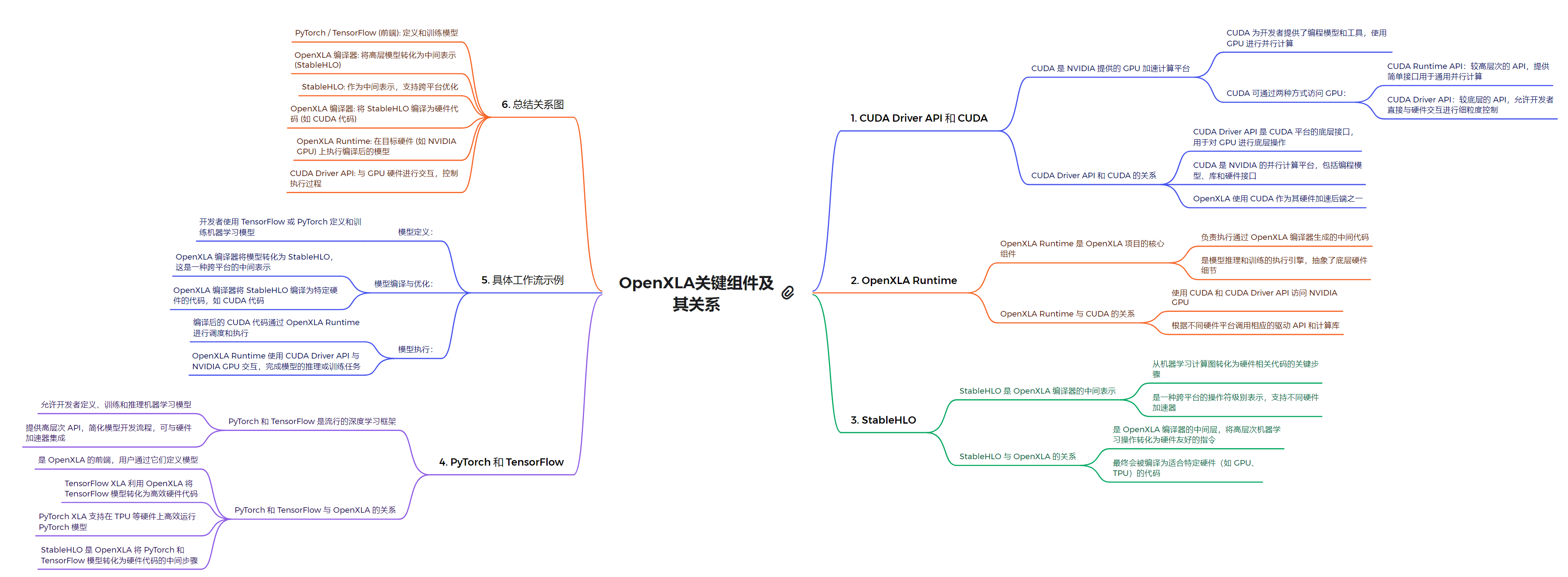

OpenXLA

OpenXLA 是 Google 开源的一个机器学习编译器框架,可以将不同的机器学习模型编译为高效的原生代码。NVIDIA 正在与 Google 合作,将 OpenXLA 与 CUDA 等技术进行集成。

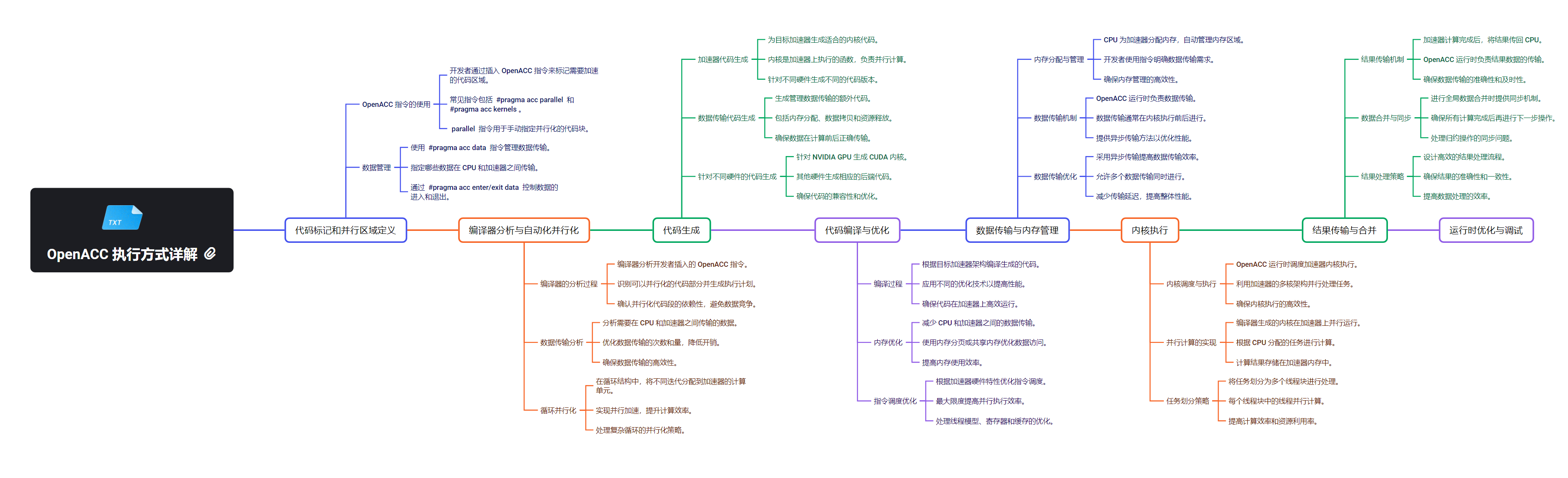

OpenACC

OpenACC 是一种指令级并行编程模型,可以让开发者更容易地将现有的 C、C++ 或 Fortran 代码移植到 GPU 上运行。OpenACC 为开发者提供了一种声明式的编程方式,无需深入了解 GPU 的底层细节。

CUDA

CUDA(Compute Unified Device Architecture)是NVIDIA公司开发的一种并行计算平台和编程模型。它允许软件开发者利用NVIDIA的GPU(图形处理单元)进行通用计算,大大提高了计算密集型任务的处理速度。

CUDA的核心概念

-

异构计算:CUDA基于CPU和GPU协同工作的异构计算模型。CPU负责管理程序流程和数据传输,而GPU负责并行计算任务。

-

线程层次结构:CUDA采用了独特的线程层次结构:

- 线程(Thread):最基本的执行单元

- 线程块(Block):由多个线程组成

- 网格(Grid):由多个线程块组成

-

内存层次结构:CUDA定义了多层内存结构,包括全局内存、共享内存、本地内存和寄存器等,以优化数据访问和管理。

CUDA的主要特点

-

高性能并行计算:利用GPU的大量计算核心,CUDA可以实现高度并行的计算,显著提升性能。

-

灵活的编程模型:CUDA扩展了C/C++语言,使开发者能够方便地编写并行程序。

-

丰富的库和工具:NVIDIA提供了众多优化库(如cuBLAS、cuDNN等)和开发工具(如CUDA Toolkit、NSight等)。

-

跨平台支持:CUDA支持Windows、Linux和macOS等多种操作系统。

-

自动伸缩性:CUDA程序可以自动适应不同的GPU硬件,实现代码的可移植性。

编写CUDA程序的基本步骤

- 初始化数据

- 将数据从主机内存传输到GPU内存

- 调用CUDA核函数执行并行计算

- 将结果从GPU内存传回主机内存

- 释放分配的内存资源

CUDA作为一种强大的并行计算平台,为开发者提供了充分利用GPU计算能力的工具。它在科学计算、人工智能等领域发挥着重要作用,推动了高性能计算的发展。然而,有效利用CUDA需要对并行编程和GPU架构有深入的理解,这也是许多开发者面临的挑战。

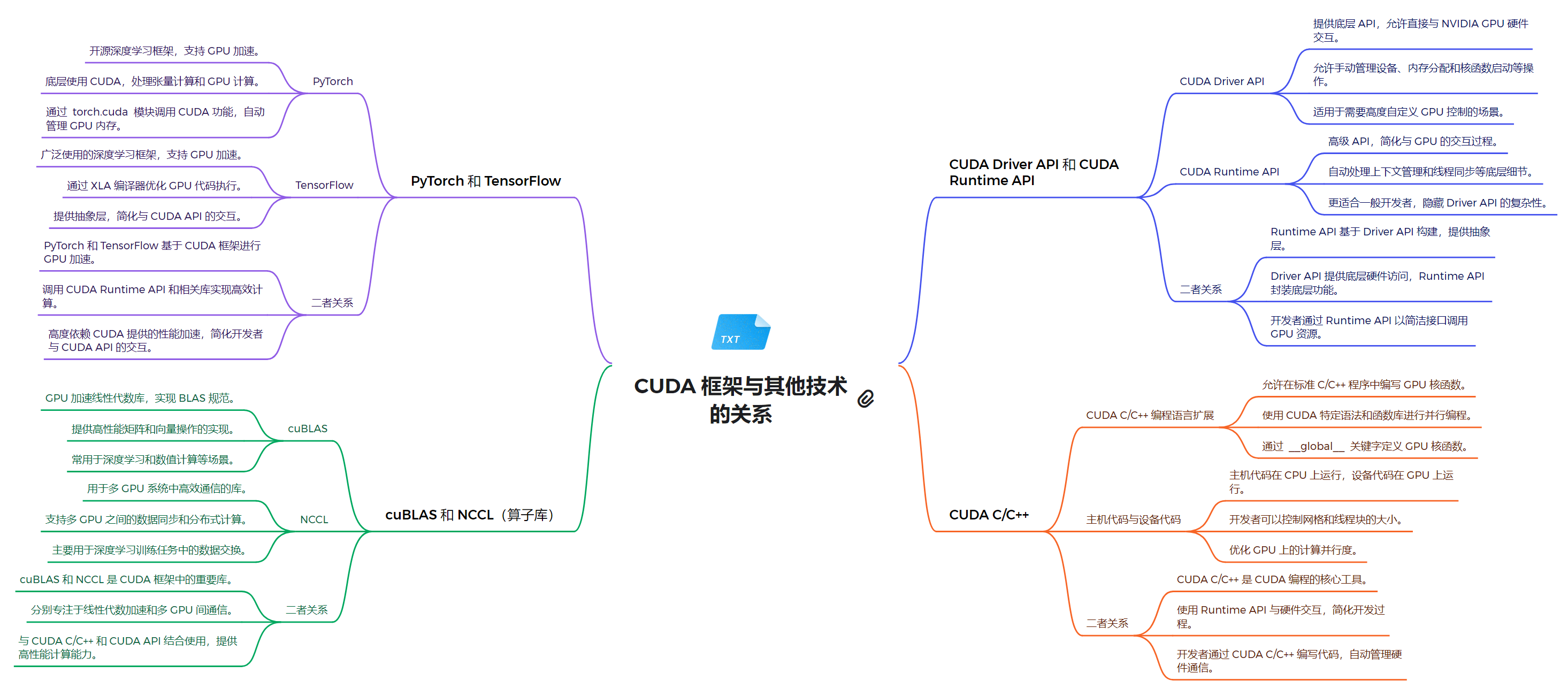

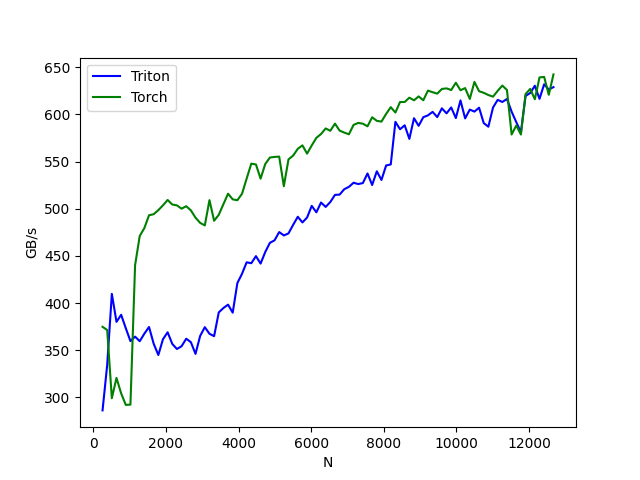

技术栈架构

1. 系统软件层

- NVIDIA GPU 驱动:为 GPU 提供基本的系统级支持

- CUDA Driver API:低级 API,提供对 GPU 的直接控制

- 允许直接管理设备、内存分配和程序执行

- 适用于需要细粒度控制的高级应用

- 提供与 NVIDIA GPU 硬件交互的底层接口

2. 运行时环境层

- CUDA Runtime API:高级 API,简化了 GPU 编程,自动管理许多底层细节

- 提供更高级的抽象,简化了 GPU 的使用

- 自动处理上下文管理和程序加载等任务

- 更适合一般开发者使用,提供了更好的易用性

3. 编程模型和语言层

- CUDA C/C++:扩展了 C/C++ 语言,允许开发者编写在 GPU 上运行的并行程序

- 允许在 CPU 和 GPU 上混合编程

- 使用 CUDA 特定语法(如

__global__)来定义 GPU 函数 - 通过

<<<>>>语法启动内核 - 支持主机代码和设备代码的混合编写

4. 计算库层

- cuBLAS:用于线性代数计算的库

- 提供 GPU 加速的矩阵运算和 BLAS 功能

- 广泛用于深度学习中的矩阵计算

- NCCL:用于多 GPU 通信的库

- 支持多 GPU 之间的高效通信和数据交换

- 主要用于分布式深度学习训练

- 其他专用算子库(如 cuDNN)

5. 框架模型层

- PyTorch:支持动态计算图的深度学习框架

- 通过

torch.cuda模块提供 CUDA 功能 - 自动管理 GPU 内存

- 支持 CPU 和 GPU 之间的数据转移

- 通过

- TensorFlow:支持静态和动态计算图的深度学习框架

- 通过 XLA 编译器优化 GPU 代码执行

- 提供高级 API,简化了 CUDA API 的使用

关系解析

- CUDA Driver API 和 CUDA Runtime API 的关系

- Runtime API 构建在 Driver API 之上,提供了更高级的抽象

- Driver API 提供更多控制,但使用更复杂

- Runtime API 更容易上手,隐藏了 Driver API 的复杂性

- 开发者可以根据需求选择使用 Runtime API 或直接使用 Driver API

- PyTorch 和 TensorFlow 与 CUDA 的关系

- 两者都基于 CUDA Runtime API 实现 GPU 加速

- 提供了高级抽象,使开发者无需直接编写 CUDA 代码

- 支持自动微分和 GPU 加速的深度学习模型训练

- PyTorch 和 TensorFlow 都支持 CPU 和 GPU 训练

- cuBLAS 和 NCCL 与 CUDA 的关系

- 这些库是 CUDA 生态系统的重要组成部分

- 它们利用 CUDA 的并行计算能力,提供高性能的数学运算和通信功能

- 与 CUDA C/C++ 和 CUDA API 结合使用,提供高性能计算能力

通过以上结构,CUDA 技术路线为开发者提供了从底层硬件控制到高层应用开发的全面支持,使得 GPU 并行计算的强大功能能够被有效地应用到各种计算密集型任务中。

系统软件层

编写了一个使用 CUDA Driver API 的程序,列出系统中可用的 CUDA 设备,获取设备的名称、计算能力、驱动版本和全局内存大小,并创建和销毁 CUDA 上下文。

-

初始化 CUDA 驱动

-

获取可用 CUDA 设备的数量,并循环遍历每个设备

-

使用 cuDeviceGetName、cuDeviceGetAttribute 、cuDeviceTotalMem和cuDriverGetVersion 获取设备的详细信息

-

创建 CUDA 上下文并设置为当前上下文

-

输出设备信息,并在结束时销毁上下文

示例代码:

#include <iostream>

#include <cuda.h>

// Check the return value of CUDA functions and print error message on failure

void checkCudaErrors(CUresult result) {

if (result != CUDA_SUCCESS) {

const char *errorStr;

cuGetErrorString(result, &errorStr);

std::cerr << "CUDA Error: " << errorStr << std::endl;

exit(EXIT_FAILURE);

}

}

// Print information about a CUDA device

void printDeviceInfo(CUdevice device) {

int driverVersion = 0;

char deviceName[256];

// Get device name

checkCudaErrors(cuDeviceGetName(deviceName, sizeof(deviceName), device));

int computeCapabilityMajor, computeCapabilityMinor;

// Get the major and minor version of compute capability

checkCudaErrors(cuDeviceGetAttribute(&computeCapabilityMajor, CU_DEVICE_ATTRIBUTE_COMPUTE_CAPABILITY_MAJOR, device));

checkCudaErrors(cuDeviceGetAttribute(&computeCapabilityMinor, CU_DEVICE_ATTRIBUTE_COMPUTE_CAPABILITY_MINOR, device));

size_t totalGlobalMem;

checkCudaErrors(cuDeviceTotalMem(&totalGlobalMem, device));

checkCudaErrors(cuDriverGetVersion(&driverVersion));

// Print device details

std::cout << "Device Name: " << deviceName << std::endl;

std::cout << "Compute Capability: " << computeCapabilityMajor << "." << computeCapabilityMinor << std::endl;

std::cout << "CUDA Driver Version: " << driverVersion / 1000 << "." << (driverVersion % 100) / 10 << std::endl;

std::cout << "Total Global Memory: " << totalGlobalMem / (1024 * 1024) << " MB" << std::endl;

}

int main() {

// Initialize CUDA

checkCudaErrors(cuInit(0));

// Get the number of available CUDA devices

int deviceCount;

checkCudaErrors(cuDeviceGetCount(&deviceCount));

std::cout << "Number of CUDA Devices: " << deviceCount << std::endl;

CUdevice device;

// Iterate through each device and print its information

for (int i = 0; i < deviceCount; i++) {

checkCudaErrors(cuDeviceGet(&device, i));

printDeviceInfo(device);

std::cout << std::endl;

}

CUcontext context;

// Create a CUDA context and set it as the current context

checkCudaErrors(cuCtxCreate(&context, 0, deviceCount > 0 ? device : 0));

checkCudaErrors(cuCtxSetCurrent(context));

std::cout << "CUDA context created successfully." << std::endl;

checkCudaErrors(cuCtxDestroy(context));

return 0;

}

结果:

Number of CUDA Devices: 1

Device Name: NVIDIA GeForce RTX 4080 SUPER

Compute Capability: 8.9

CUDA Driver Version: 12.4

Total Global Memory: 16072 MB

CUDA context created successfully.

运行时环境层

CUDA Runtime API 是 NVIDIA 提供的用于管理和使用 GPU 资源的接口,旨在简化开发者与 CUDA 设备之间的交互。该 API 支持多种功能,包括设备查询、内存管理和流控制等,极大地提高了 GPU 编程的效率和可用性。

参考仓库地址:deviceQuery

示例代码如下:

/* Copyright (c) 2022, NVIDIA CORPORATION. All rights reserved.

*

* Redistribution and use in source and binary forms, with or without

* modification, are permitted provided that the following conditions

* are met:

* * Redistributions of source code must retain the above copyright

* notice, this list of conditions and the following disclaimer.

* * Redistributions in binary form must reproduce the above copyright

* notice, this list of conditions and the following disclaimer in the

* documentation and/or other materials provided with the distribution.

* * Neither the name of NVIDIA CORPORATION nor the names of its

* contributors may be used to endorse or promote products derived

* from this software without specific prior written permission.

*

* THIS SOFTWARE IS PROVIDED BY THE COPYRIGHT HOLDERS ``AS IS'' AND ANY

* EXPRESS OR IMPLIED WARRANTIES, INCLUDING, BUT NOT LIMITED TO, THE

* IMPLIED WARRANTIES OF MERCHANTABILITY AND FITNESS FOR A PARTICULAR

* PURPOSE ARE DISCLAIMED. IN NO EVENT SHALL THE COPYRIGHT OWNER OR

* CONTRIBUTORS BE LIABLE FOR ANY DIRECT, INDIRECT, INCIDENTAL, SPECIAL,

* EXEMPLARY, OR CONSEQUENTIAL DAMAGES (INCLUDING, BUT NOT LIMITED TO,

* PROCUREMENT OF SUBSTITUTE GOODS OR SERVICES; LOSS OF USE, DATA, OR

* PROFITS; OR BUSINESS INTERRUPTION) HOWEVER CAUSED AND ON ANY THEORY

* OF LIABILITY, WHETHER IN CONTRACT, STRICT LIABILITY, OR TORT

* (INCLUDING NEGLIGENCE OR OTHERWISE) ARISING IN ANY WAY OUT OF THE USE

* OF THIS SOFTWARE, EVEN IF ADVISED OF THE POSSIBILITY OF SUCH DAMAGE.

*/

/* This sample queries the properties of the CUDA devices present in the system

* via CUDA Runtime API. */

// std::system includes

#include <cuda_runtime.h>

#include <helper_cuda.h>

#include <iostream>

#include <memory>

#include <string>

int *pArgc = NULL;

char **pArgv = NULL;

#if CUDART_VERSION < 5000

// This function wraps the CUDA Driver API into a template function

template <class T>

inline void getCudaAttribute(T *attribute, CUdevice_attribute device_attribute,

int device) {

CUresult error = cuDeviceGetAttribute(attribute, device_attribute, device);

if (CUDA_SUCCESS != error) {

fprintf(

stderr,

"cuSafeCallNoSync() Driver API error = %04d from file <%s>, line %i.\n",

error, __FILE__, __LINE__);

exit(EXIT_FAILURE);

}

}

#endif /* CUDART_VERSION < 5000 */

////////////////////////////////////////////////////////////////////////////////

// Program main

////////////////////////////////////////////////////////////////////////////////

int main(int argc, char **argv) {

pArgc = &argc;

pArgv = argv;

printf("%s Starting...\n\n", argv[0]);

printf(

" CUDA Device Query (Runtime API) version (CUDART static linking)\n\n");

int deviceCount = 0;

cudaError_t error_id = cudaGetDeviceCount(&deviceCount);

if (error_id != cudaSuccess) {

printf("cudaGetDeviceCount returned %d\n-> %s\n",

static_cast<int>(error_id), cudaGetErrorString(error_id));

printf("Result = FAIL\n");

exit(EXIT_FAILURE);

}

// This function call returns 0 if there are no CUDA capable devices.

if (deviceCount == 0) {

printf("There are no available device(s) that support CUDA\n");

} else {

printf("Detected %d CUDA Capable device(s)\n", deviceCount);

}

int dev, driverVersion = 0, runtimeVersion = 0;

for (dev = 0; dev < deviceCount; ++dev) {

cudaSetDevice(dev);

cudaDeviceProp deviceProp;

cudaGetDeviceProperties(&deviceProp, dev);

printf("\nDevice %d: \"%s\"\n", dev, deviceProp.name);

// Console log

cudaDriverGetVersion(&driverVersion);

cudaRuntimeGetVersion(&runtimeVersion);

printf(" CUDA Driver Version / Runtime Version %d.%d / %d.%d\n",

driverVersion / 1000, (driverVersion % 100) / 10,

runtimeVersion / 1000, (runtimeVersion % 100) / 10);

printf(" CUDA Capability Major/Minor version number: %d.%d\n",

deviceProp.major, deviceProp.minor);

char msg[256];

#if defined(WIN32) || defined(_WIN32) || defined(WIN64) || defined(_WIN64)

sprintf_s(msg, sizeof(msg),

" Total amount of global memory: %.0f MBytes "

"(%llu bytes)\n",

static_cast<float>(deviceProp.totalGlobalMem / 1048576.0f),

(unsigned long long)deviceProp.totalGlobalMem);

#else

snprintf(msg, sizeof(msg),

" Total amount of global memory: %.0f MBytes "

"(%llu bytes)\n",

static_cast<float>(deviceProp.totalGlobalMem / 1048576.0f),

(unsigned long long)deviceProp.totalGlobalMem);

#endif

printf("%s", msg);

printf(" (%03d) Multiprocessors, (%03d) CUDA Cores/MP: %d CUDA Cores\n",

deviceProp.multiProcessorCount,

_ConvertSMVer2Cores(deviceProp.major, deviceProp.minor),

_ConvertSMVer2Cores(deviceProp.major, deviceProp.minor) *

deviceProp.multiProcessorCount);

printf(

" GPU Max Clock rate: %.0f MHz (%0.2f "

"GHz)\n",

deviceProp.clockRate * 1e-3f, deviceProp.clockRate * 1e-6f);

#if CUDART_VERSION >= 5000

// This is supported in CUDA 5.0 (runtime API device properties)

printf(" Memory Clock rate: %.0f Mhz\n",

deviceProp.memoryClockRate * 1e-3f);

printf(" Memory Bus Width: %d-bit\n",

deviceProp.memoryBusWidth);

if (deviceProp.l2CacheSize) {

printf(" L2 Cache Size: %d bytes\n",

deviceProp.l2CacheSize);

}

#else

// This only available in CUDA 4.0-4.2 (but these were only exposed in the

// CUDA Driver API)

int memoryClock;

getCudaAttribute<int>(&memoryClock, CU_DEVICE_ATTRIBUTE_MEMORY_CLOCK_RATE,

dev);

printf(" Memory Clock rate: %.0f Mhz\n",

memoryClock * 1e-3f);

int memBusWidth;

getCudaAttribute<int>(&memBusWidth,

CU_DEVICE_ATTRIBUTE_GLOBAL_MEMORY_BUS_WIDTH, dev);

printf(" Memory Bus Width: %d-bit\n",

memBusWidth);

int L2CacheSize;

getCudaAttribute<int>(&L2CacheSize, CU_DEVICE_ATTRIBUTE_L2_CACHE_SIZE, dev);

if (L2CacheSize) {

printf(" L2 Cache Size: %d bytes\n",

L2CacheSize);

}

#endif

printf(

" Maximum Texture Dimension Size (x,y,z) 1D=(%d), 2D=(%d, "

"%d), 3D=(%d, %d, %d)\n",

deviceProp.maxTexture1D, deviceProp.maxTexture2D[0],

deviceProp.maxTexture2D[1], deviceProp.maxTexture3D[0],

deviceProp.maxTexture3D[1], deviceProp.maxTexture3D[2]);

printf(

" Maximum Layered 1D Texture Size, (num) layers 1D=(%d), %d layers\n",

deviceProp.maxTexture1DLayered[0], deviceProp.maxTexture1DLayered[1]);

printf(

" Maximum Layered 2D Texture Size, (num) layers 2D=(%d, %d), %d "

"layers\n",

deviceProp.maxTexture2DLayered[0], deviceProp.maxTexture2DLayered[1],

deviceProp.maxTexture2DLayered[2]);

printf(" Total amount of constant memory: %zu bytes\n",

deviceProp.totalConstMem);

printf(" Total amount of shared memory per block: %zu bytes\n",

deviceProp.sharedMemPerBlock);

printf(" Total shared memory per multiprocessor: %zu bytes\n",

deviceProp.sharedMemPerMultiprocessor);

printf(" Total number of registers available per block: %d\n",

deviceProp.regsPerBlock);

printf(" Warp size: %d\n",

deviceProp.warpSize);

printf(" Maximum number of threads per multiprocessor: %d\n",

deviceProp.maxThreadsPerMultiProcessor);

printf(" Maximum number of threads per block: %d\n",

deviceProp.maxThreadsPerBlock);

printf(" Max dimension size of a thread block (x,y,z): (%d, %d, %d)\n",

deviceProp.maxThreadsDim[0], deviceProp.maxThreadsDim[1],

deviceProp.maxThreadsDim[2]);

printf(" Max dimension size of a grid size (x,y,z): (%d, %d, %d)\n",

deviceProp.maxGridSize[0], deviceProp.maxGridSize[1],

deviceProp.maxGridSize[2]);

printf(" Maximum memory pitch: %zu bytes\n",

deviceProp.memPitch);

printf(" Texture alignment: %zu bytes\n",

deviceProp.textureAlignment);

printf(

" Concurrent copy and kernel execution: %s with %d copy "

"engine(s)\n",

(deviceProp.deviceOverlap ? "Yes" : "No"), deviceProp.asyncEngineCount);

printf(" Run time limit on kernels: %s\n",

deviceProp.kernelExecTimeoutEnabled ? "Yes" : "No");

printf(" Integrated GPU sharing Host Memory: %s\n",

deviceProp.integrated ? "Yes" : "No");

printf(" Support host page-locked memory mapping: %s\n",

deviceProp.canMapHostMemory ? "Yes" : "No");

printf(" Alignment requirement for Surfaces: %s\n",

deviceProp.surfaceAlignment ? "Yes" : "No");

printf(" Device has ECC support: %s\n",

deviceProp.ECCEnabled ? "Enabled" : "Disabled");

#if defined(WIN32) || defined(_WIN32) || defined(WIN64) || defined(_WIN64)

printf(" CUDA Device Driver Mode (TCC or WDDM): %s\n",

deviceProp.tccDriver ? "TCC (Tesla Compute Cluster Driver)"

: "WDDM (Windows Display Driver Model)");

#endif

printf(" Device supports Unified Addressing (UVA): %s\n",

deviceProp.unifiedAddressing ? "Yes" : "No");

printf(" Device supports Managed Memory: %s\n",

deviceProp.managedMemory ? "Yes" : "No");

printf(" Device supports Compute Preemption: %s\n",

deviceProp.computePreemptionSupported ? "Yes" : "No");

printf(" Supports Cooperative Kernel Launch: %s\n",

deviceProp.cooperativeLaunch ? "Yes" : "No");

printf(" Supports MultiDevice Co-op Kernel Launch: %s\n",

deviceProp.cooperativeMultiDeviceLaunch ? "Yes" : "No");

printf(" Device PCI Domain ID / Bus ID / location ID: %d / %d / %d\n",

deviceProp.pciDomainID, deviceProp.pciBusID, deviceProp.pciDeviceID);

const char *sComputeMode[] = {

"Default (multiple host threads can use ::cudaSetDevice() with device "

"simultaneously)",

"Exclusive (only one host thread in one process is able to use "

"::cudaSetDevice() with this device)",

"Prohibited (no host thread can use ::cudaSetDevice() with this "

"device)",

"Exclusive Process (many threads in one process is able to use "

"::cudaSetDevice() with this device)",

"Unknown", NULL};

printf(" Compute Mode:\n");

printf(" < %s >\n", sComputeMode[deviceProp.computeMode]);

}

// If there are 2 or more GPUs, query to determine whether RDMA is supported

if (deviceCount >= 2) {

cudaDeviceProp prop[64];

int gpuid[64]; // we want to find the first two GPUs that can support P2P

int gpu_p2p_count = 0;

for (int i = 0; i < deviceCount; i++) {

checkCudaErrors(cudaGetDeviceProperties(&prop[i], i));

// Only boards based on Fermi or later can support P2P

if ((prop[i].major >= 2)

#if defined(WIN32) || defined(_WIN32) || defined(WIN64) || defined(_WIN64)

// on Windows (64-bit), the Tesla Compute Cluster driver for windows

// must be enabled to support this

&& prop[i].tccDriver

#endif

) {

// This is an array of P2P capable GPUs

gpuid[gpu_p2p_count++] = i;

}

}

// Show all the combinations of support P2P GPUs

int can_access_peer;

if (gpu_p2p_count >= 2) {

for (int i = 0; i < gpu_p2p_count; i++) {

for (int j = 0; j < gpu_p2p_count; j++) {

if (gpuid[i] == gpuid[j]) {

continue;

}

checkCudaErrors(

cudaDeviceCanAccessPeer(&can_access_peer, gpuid[i], gpuid[j]));

printf("> Peer access from %s (GPU%d) -> %s (GPU%d) : %s\n",

prop[gpuid[i]].name, gpuid[i], prop[gpuid[j]].name, gpuid[j],

can_access_peer ? "Yes" : "No");

}

}

}

}

// csv masterlog info

// *****************************

// exe and CUDA driver name

printf("\n");

std::string sProfileString = "deviceQuery, CUDA Driver = CUDART";

char cTemp[16];

// driver version

sProfileString += ", CUDA Driver Version = ";

#if defined(WIN32) || defined(_WIN32) || defined(WIN64) || defined(_WIN64)

sprintf_s(cTemp, 10, "%d.%d", driverVersion / 1000,

(driverVersion % 100) / 10);

#else

snprintf(cTemp, sizeof(cTemp), "%d.%d", driverVersion / 1000,

(driverVersion % 100) / 10);

#endif

sProfileString += cTemp;

// Runtime version

sProfileString += ", CUDA Runtime Version = ";

#if defined(WIN32) || defined(_WIN32) || defined(WIN64) || defined(_WIN64)

sprintf_s(cTemp, 10, "%d.%d", runtimeVersion / 1000,

(runtimeVersion % 100) / 10);

#else

snprintf(cTemp, sizeof(cTemp), "%d.%d", runtimeVersion / 1000,

(runtimeVersion % 100) / 10);

#endif

sProfileString += cTemp;

// Device count

sProfileString += ", NumDevs = ";

#if defined(WIN32) || defined(_WIN32) || defined(WIN64) || defined(_WIN64)

sprintf_s(cTemp, 10, "%d", deviceCount);

#else

snprintf(cTemp, sizeof(cTemp), "%d", deviceCount);

#endif

sProfileString += cTemp;

sProfileString += "\n";

printf("%s", sProfileString.c_str());

printf("Result = PASS\n");

// finish

exit(EXIT_SUCCESS);

}

结果:

./Samples/1_Utilities/deviceQuery/deviceQuery Starting...

CUDA Device Query (Runtime API) version (CUDART static linking)

Detected 1 CUDA Capable device(s)

Device 0: "NVIDIA GeForce RTX 4080 SUPER"

CUDA Driver Version / Runtime Version 12.4 / 12.3

CUDA Capability Major/Minor version number: 8.9

Total amount of global memory: 16072 MBytes (16852844544 bytes)

(080) Multiprocessors, (128) CUDA Cores/MP: 10240 CUDA Cores

GPU Max Clock rate: 2550 MHz (2.55 GHz)

Memory Clock rate: 11501 Mhz

Memory Bus Width: 256-bit

L2 Cache Size: 67108864 bytes

Maximum Texture Dimension Size (x,y,z) 1D=(131072), 2D=(131072, 65536), 3D=(16384, 16384, 16384)

Maximum Layered 1D Texture Size, (num) layers 1D=(32768), 2048 layers

Maximum Layered 2D Texture Size, (num) layers 2D=(32768, 32768), 2048 layers

Total amount of constant memory: 65536 bytes

Total amount of shared memory per block: 49152 bytes

Total shared memory per multiprocessor: 102400 bytes

Total number of registers available per block: 65536

Warp size: 32

Maximum number of threads per multiprocessor: 1536

Maximum number of threads per block: 1024

Max dimension size of a thread block (x,y,z): (1024, 1024, 64)

Max dimension size of a grid size (x,y,z): (2147483647, 65535, 65535)

Maximum memory pitch: 2147483647 bytes

Texture alignment: 512 bytes

Concurrent copy and kernel execution: Yes with 2 copy engine(s)

Run time limit on kernels: Yes

Integrated GPU sharing Host Memory: No

Support host page-locked memory mapping: Yes

Alignment requirement for Surfaces: Yes

Device has ECC support: Disabled

Device supports Unified Addressing (UVA): Yes

Device supports Managed Memory: Yes

Device supports Compute Preemption: Yes

Supports Cooperative Kernel Launch: Yes

Supports MultiDevice Co-op Kernel Launch: Yes

Device PCI Domain ID / Bus ID / location ID: 0 / 1 / 0

Compute Mode:

< Default (multiple host threads can use ::cudaSetDevice() with device simultaneously) >

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 12.4, CUDA Runtime Version = 12.3, NumDevs = 1

Result = PASS

编程模型和语言层

CUDA 允许开发者使用 C/C++ 扩展语言直接编写可在 NVIDIA GPU 上执行的高效代码,通过将计算任务划分为大量细粒度的并行线程,实现了对大规模数据并行处理的支持,广泛应用于AI模型的训练和推理等任务中。

1. CUDA 的核心编程特性

CUDA编程模型为开发者提供了多种独特的编程特性,帮助其利用GPU进行高效的并行计算:

- 设备与主机内存管理 :CUDA 将 GPU 称为“设备”,而 CPU 称为“主机”。开发者必须明确管理主机与设备之间的数据传输,通常通过

cudaMalloc、cudaMemcpy等函数在主机内存和设备内存之间进行操作。 - 内核函数(Kernel) :CUDA 的并行计算是通过内核函数实现的,内核函数在设备上执行,并可以并发地处理大量数据。内核函数使用

__global__修饰,定义其在GPU上运行。 示例:

__global__ void vectorAdd(const float* A, const float* B, float* C, int N) {

int i = blockDim.x * blockIdx.x + threadIdx.x;

if (i < N) C[i] = A[i] + B[i];

}

该示例展示了如何利用GPU并行计算两个向量的加法操作。blockIdx.x、threadIdx.x 是 CUDA 的独特变量,用于标识并发执行的线程和块。

- 线程和块模型 :CUDA 的核心编程模型是 网格(grid) 和 块(block) 的层次结构。在执行任务时,开发者需要划分数据并指定每个块和每个线程的数量,借此划分任务粒度,控制计算并行性。

- 共享内存和同步机制 :CUDA 设备内的共享内存为同一块内的所有线程提供了快速的数据访问。开发者还可以使用同步机制(如

__syncthreads())来确保线程间的通信和数据一致性。

2. 算子编写示例:矩阵乘法

矩阵乘法是AI和深度学习中的重要操作,下面展示如何在CUDA中实现并行化的矩阵乘法:

__global__ void matrixMul(const float* A, const float* B, float* C, int N) {

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

float result = 0.0;

if(row < N && col < N) {

for (int i = 0; i < N; ++i) {

result += A[row * N + i] * B[i * N + col];

}

C[row * N + col] = result;

}

}

在这个实现中,使用了二维的线程和块索引 blockIdx.x, blockIdx.y, threadIdx.x, threadIdx.y 来定位矩阵中的元素。这种方式可以极大提升计算的并行化程度,尤其适合大规模矩阵的乘法运算。

3. 并行计算模型介绍

CUDA 的并行计算模型是基于以下几个关键概念:

- SIMT(Single Instruction, Multiple Threads)模型 :CUDA 采用了类似于 SIMD 的并行计算模式,称为SIMT。它允许每个线程执行相同的指令集,但操作不同的数据。这种设计使得CUDA的线程管理更加灵活,也增强了硬件并行处理的效率。

- Warp和线程块(Thread Block) :在CUDA中,32个线程被组织为一个 “warp”,并且同一个warp中的线程执行同步的指令。多个warp再组成线程块(thread block)。这是CUDA执行的基本单位,所有线程在同一块中共享内存,具备较低的通信延迟。

- 内存层次结构 :CUDA 提供了多层次的内存,包括全局内存(global memory)、共享内存(shared memory)和局部寄存器(local register)。合理分配和使用这些不同级别的内存是性能优化的关键。

4. CUDA 与 AI 开发中的应用

在AI开发中,CUDA 的广泛应用主要体现在以下方面:

- 深度学习模型训练 :深度学习中的反向传播算法依赖于大规模矩阵运算,而CUDA为此类计算提供了并行化支持,极大提升了模型训练的速度。

- 推理加速 :使用 CUDA 可以在推理阶段加速神经网络的前向传播,尤其在嵌入式设备或边缘计算中,CUDA 提供了可行的GPU加速方案。

- 优化库 :NVIDIA 提供了如 cuBLAS、cuDNN 等高度优化的CUDA库,这些库实现了诸如矩阵乘法、卷积等高效算子,是深度学习框架(如 TensorFlow、PyTorch)的基础。

5. 总结

CUDA 提供了一套强大的并行编程模型,使开发者能够高效利用NVIDIA GPU的计算资源。通过其灵活的线程和块设计、内存层次结构以及丰富的优化库支持,CUDA 成为AI开发不可或缺的工具之一。然而,其依赖于特定硬件平台的局限性,也要求开发者在设计系统时考虑跨平台兼容性的问题。

计算库层

cuBLAS 是 NVIDIA 提供的高性能线性代数库,专为 CUDA 平台优化,支持多种基本线性代数操作,如矩阵乘法、向量运算和矩阵分解。cuBLAS 利用 GPU 的并行计算能力,提供高效的内存访问模式和自动优化的内核,能够显著提升矩阵运算的性能。

参考仓库地址:cuda-samples

例如,矩阵乘法(GEMM)操作可以通过 cuBLAS 的简单接口实现。

示例代码如下:

// System includes

#include <stdio.h>

#include <assert.h>

// CUDA runtime

#include <cuda_runtime.h>

#include <cuda_profiler_api.h>

// Helper functions and utilities to work with CUDA

#include <helper_functions.h>

#include <helper_cuda.h>

// cuBLAS library

#include <cublas_v2.h>

void ConstantInit(float *data, int size, float val) {

for (int i = 0; i < size; ++i) {

data[i] = val;

}

}

/**

* Run a simple test of matrix multiplication using cuBLAS

*/

int MatrixMultiply(int argc, char **argv,

const dim3 &dimsA,

const dim3 &dimsB) {

// Allocate host memory for matrices A and B

unsigned int size_A = dimsA.x * dimsA.y;

unsigned int mem_size_A = sizeof(float) * size_A;

float *h_A;

checkCudaErrors(cudaMallocHost(&h_A, mem_size_A));

unsigned int size_B = dimsB.x * dimsB.y;

unsigned int mem_size_B = sizeof(float) * size_B;

float *h_B;

checkCudaErrors(cudaMallocHost(&h_B, mem_size_B));

cudaStream_t stream;

// Initialize host memory

const float valB = 0.01f;

ConstantInit(h_A, size_A, 1.0f);

ConstantInit(h_B, size_B, valB);

// Allocate device memory

float *d_A, *d_B, *d_C;

// Allocate host matrix C

dim3 dimsC(dimsB.x, dimsA.y, 1);

unsigned int mem_size_C = dimsC.x * dimsC.y * sizeof(float);

float *h_C;

checkCudaErrors(cudaMallocHost(&h_C, mem_size_C));

if (h_C == NULL) {

fprintf(stderr, "Failed to allocate host matrix C!\n");

exit(EXIT_FAILURE);

}

checkCudaErrors(cudaMalloc(reinterpret_cast<void **>(&d_A), mem_size_A));

checkCudaErrors(cudaMalloc(reinterpret_cast<void **>(&d_B), mem_size_B));

checkCudaErrors(cudaMalloc(reinterpret_cast<void **>(&d_C), mem_size_C));

// Allocate CUDA events that we'll use for timing

cudaEvent_t start, stop;

checkCudaErrors(cudaEventCreate(&start));

checkCudaErrors(cudaEventCreate(&stop));

checkCudaErrors(cudaStreamCreateWithFlags(&stream, cudaStreamNonBlocking));

// Copy host memory to device

checkCudaErrors(

cudaMemcpyAsync(d_A, h_A, mem_size_A, cudaMemcpyHostToDevice, stream));

checkCudaErrors(

cudaMemcpyAsync(d_B, h_B, mem_size_B, cudaMemcpyHostToDevice, stream));

// Record the start event

checkCudaErrors(cudaEventRecord(start, stream));

// Execute the cuBLAS matrix multiplication

int nIter = 300;

cublasHandle_t handle;

cublasCreate(&handle);

const float alpha = 1.0f;

const float beta = 0.0f;

for (int j = 0; j < nIter; j++) {

cublasSgemm(handle, CUBLAS_OP_N, CUBLAS_OP_N,

dimsB.x, dimsA.y, dimsA.x,

&alpha,

d_B, dimsB.x,

d_A, dimsA.x,

&beta,

d_C, dimsB.x);

}

// Record the stop event

checkCudaErrors(cudaEventRecord(stop, stream));

checkCudaErrors(cudaEventSynchronize(stop));

float msecTotal = 0.0f;

checkCudaErrors(cudaEventElapsedTime(&msecTotal, start, stop));

// Compute and print the performance

float msecPerMatrixMul = msecTotal / nIter;

double flopsPerMatrixMul = 2.0 * static_cast<double>(dimsA.x) *

static_cast<double>(dimsA.y) *

static_cast<double>(dimsB.x);

double gigaFlops =

(flopsPerMatrixMul * 1.0e-9f) / (msecPerMatrixMul / 1000.0f);

printf("cuBLAS Performance= %.2f GFlop/s, Time= %.3f msec\n",

gigaFlops, msecPerMatrixMul);

// Copy result from device to host

checkCudaErrors(

cudaMemcpyAsync(h_C, d_C, mem_size_C, cudaMemcpyDeviceToHost, stream));

checkCudaErrors(cudaStreamSynchronize(stream));

cublasDestroy(handle);

// Clean up memory

checkCudaErrors(cudaFreeHost(h_A));

checkCudaErrors(cudaFreeHost(h_B));

checkCudaErrors(cudaFreeHost(h_C));

checkCudaErrors(cudaFree(d_A));

checkCudaErrors(cudaFree(d_B));

checkCudaErrors(cudaFree(d_C));

checkCudaErrors(cudaEventDestroy(start));

checkCudaErrors(cudaEventDestroy(stop));

return EXIT_SUCCESS;

}

int main(int argc, char **argv) {

printf("[Matrix Multiply Using cuBLAS] - Starting...\n");

if (checkCmdLineFlag(argc, (const char **)argv, "help") ||

checkCmdLineFlag(argc, (const char **)argv, "?")) {

printf("Usage -device=n (n >= 0 for deviceID)\n");

printf(" -wA=WidthA -hA=HeightA (Width x Height of Matrix A)\n");

printf(" -wB=WidthB -hB=HeightB (Width x Height of Matrix B)\n");

printf(" Note: Outer matrix dimensions of A & B matrices" \

" must be equal.\n");

exit(EXIT_SUCCESS);

}

dim3 dimsA(320, 320, 1);

dim3 dimsB(320, 320, 1);

// Width of Matrix A

if (checkCmdLineFlag(argc, (const char **)argv, "wA")) {

dimsA.x = getCmdLineArgumentInt(argc, (const char **)argv, "wA");

}

// Height of Matrix A

if (checkCmdLineFlag(argc, (const char **)argv, "hA")) {

dimsA.y = getCmdLineArgumentInt(argc, (const char **)argv, "hA");

}

// Width of Matrix B

if (checkCmdLineFlag(argc, (const char **)argv, "wB")) {

dimsB.x = getCmdLineArgumentInt(argc, (const char **)argv, "wB");

}

// Height of Matrix B

if (checkCmdLineFlag(argc, (const char **)argv, "hB")) {

dimsB.y = getCmdLineArgumentInt(argc, (const char **)argv, "hB");

}

if (dimsA.x != dimsB.y) {

printf("Error: outer matrix dimensions must be equal. (%d != %d)\n",

dimsA.x, dimsB.y);

exit(EXIT_FAILURE);

}

printf("MatrixA(%d,%d), MatrixB(%d,%d)\n", dimsA.x, dimsA.y,

dimsB.x, dimsB.y);

checkCudaErrors(cudaProfilerStart());

int matrix_result = MatrixMultiply(argc, argv, dimsA, dimsB);

checkCudaErrors(cudaProfilerStop());

exit(matrix_result);

}

结果:

[Matrix Multiply Using cuBLAS] - Starting...

MatrixA(320,320), MatrixB(320,320)

cuBLAS Performance= 1752.85 GFlop/s, Time= 0.037 msec

参考仓库地址:sample2

矩阵加法代码示例

#include <cstdio>

#include <cstdlib>

#include <vector>

#include <cublas_v2.h>

#include <cuda_runtime.h>

#include "cublas_utils.h"

using data_type = double;

int main(int argc, char *argv[]) {

cublasHandle_t cublasH = NULL;

cudaStream_t stream = NULL;

const int m = 2;

const int n = 2;

const int k = 2;

const int lda = 2;

const int ldb = 2;

const int ldc = 2;

/*

* A = | 1.0 | 2.0 |

* | 3.0 | 4.0 |

*

* B = | 5.0 | 6.0 |

* | 7.0 | 8.0 |

*/

const std::vector<data_type> A = {1.0, 3.0, 2.0, 4.0};

const std::vector<data_type> B = {5.0, 7.0, 6.0, 8.0};

std::vector<data_type> C(m * n);

const data_type alpha = 1.0;

const data_type beta = 2.0;

data_type *d_A = nullptr;

data_type *d_B = nullptr;

data_type *d_C = nullptr;

cublasOperation_t transa = CUBLAS_OP_N;

cublasOperation_t transb = CUBLAS_OP_N;

printf("A\n");

print_matrix(m, k, A.data(), lda);

printf("=====\n");

printf("B\n");

print_matrix(k, n, B.data(), ldb);

printf("=====\n");

/* step 1: create cublas handle, bind a stream */

CUBLAS_CHECK(cublasCreate(&cublasH));

CUDA_CHECK(cudaStreamCreateWithFlags(&stream, cudaStreamNonBlocking));

CUBLAS_CHECK(cublasSetStream(cublasH, stream));

/* step 2: copy data to device */

CUDA_CHECK(cudaMalloc(reinterpret_cast<void **>(&d_A), sizeof(data_type) * A.size()));

CUDA_CHECK(cudaMalloc(reinterpret_cast<void **>(&d_B), sizeof(data_type) * B.size()));

CUDA_CHECK(cudaMalloc(reinterpret_cast<void **>(&d_C), sizeof(data_type) * C.size()));

CUDA_CHECK(cudaMemcpyAsync(d_A, A.data(), sizeof(data_type) * A.size(), cudaMemcpyHostToDevice,

stream));

CUDA_CHECK(cudaMemcpyAsync(d_B, B.data(), sizeof(data_type) * B.size(), cudaMemcpyHostToDevice,

stream));

/* step 3: compute */

CUBLAS_CHECK(

cublasDgeam(cublasH, transa, transb, m, n, &alpha, d_A, lda, &beta, d_B, ldb, d_C, ldc));

/* step 4: copy data to host */

CUDA_CHECK(cudaMemcpyAsync(C.data(), d_C, sizeof(data_type) * C.size(), cudaMemcpyDeviceToHost,

stream));

CUDA_CHECK(cudaStreamSynchronize(stream));

/*

* C = | 11.0 | 14.0 |

* | 17.0 | 20.0 |

*/

printf("C\n");

print_matrix(m, n, C.data(), ldc);

printf("=====\n");

/* free resources */

CUDA_CHECK(cudaFree(d_A));

CUDA_CHECK(cudaFree(d_B));

CUDA_CHECK(cudaFree(d_C));

CUBLAS_CHECK(cublasDestroy(cublasH));

CUDA_CHECK(cudaStreamDestroy(stream));

CUDA_CHECK(cudaDeviceReset());

return EXIT_SUCCESS;

}

编译命令

nvcc [头文件地址] -o 编译后文件名称 编译前文件名称 [库链接]

结果

1.00 2.00

3.00 4.00

=====

B

5.00 6.00

7.00 8.00

=====

C

11.00 14.00

17.00 20.00

=====

参考仓库地址:sample3

矩阵加法代码示例

#include <cstdio>

#include <cstdlib>

#include <vector>

#include <cublas_v2.h>

#include <cuda_runtime.h>

#include "cublas_utils.h"

using data_type = double;

int main(int argc, char *argv[]) {

cublasHandle_t cublasH = NULL;

cudaStream_t stream = NULL;

/*

* A = | 1.0 2.0 3.0 4.0 |

*/

std::vector<data_type> A = {1.0, 2.0, 3.0, 4.0};

const int incx = 1;

data_type result = 0.0;

data_type *d_A = nullptr;

printf("A\n");

print_vector(A.size(), A.data());

printf("=====\n");

/* step 1: create cublas handle, bind a stream */

CUBLAS_CHECK(cublasCreate(&cublasH));

CUDA_CHECK(cudaStreamCreateWithFlags(&stream, cudaStreamNonBlocking));

CUBLAS_CHECK(cublasSetStream(cublasH, stream));

/* step 2: copy data to device */

CUDA_CHECK(cudaMalloc(reinterpret_cast<void **>(&d_A), sizeof(data_type) * A.size()));

CUDA_CHECK(cudaMemcpyAsync(d_A, A.data(), sizeof(data_type) * A.size(), cudaMemcpyHostToDevice,

stream));

/* step 3: compute */

CUBLAS_CHECK(cublasNrm2Ex(cublasH, A.size(), d_A, traits<data_type>::cuda_data_type, incx,

&result, traits<data_type>::cuda_data_type,

traits<data_type>::cuda_data_type));

/* step 4: copy data to host */

CUDA_CHECK(cudaMemcpyAsync(A.data(), d_A, sizeof(data_type) * A.size(), cudaMemcpyDeviceToHost,

stream));

CUDA_CHECK(cudaStreamSynchronize(stream));

/*

* Result = 5.48

*/

printf("Result\n");

printf("%0.2f\n", result);

printf("=====\n");

/* free resources */

CUDA_CHECK(cudaFree(d_A));

CUBLAS_CHECK(cublasDestroy(cublasH));

CUDA_CHECK(cudaStreamDestroy(stream));

CUDA_CHECK(cudaDeviceReset());

return EXIT_SUCCESS;

}

编译命令

nvcc [头文件地址] -o 编译后文件名称 编译前文件名称 [库链接]

结果

A

1.00 2.00 3.00 4.00

=====

Result

5.48

=====

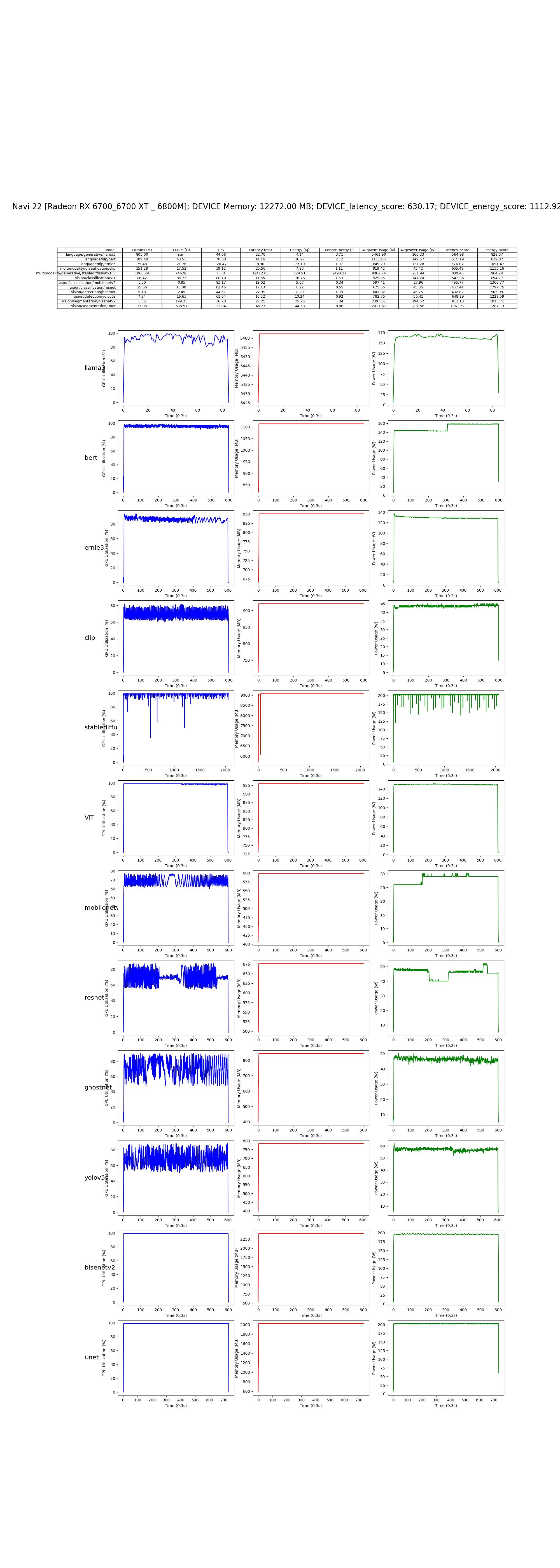

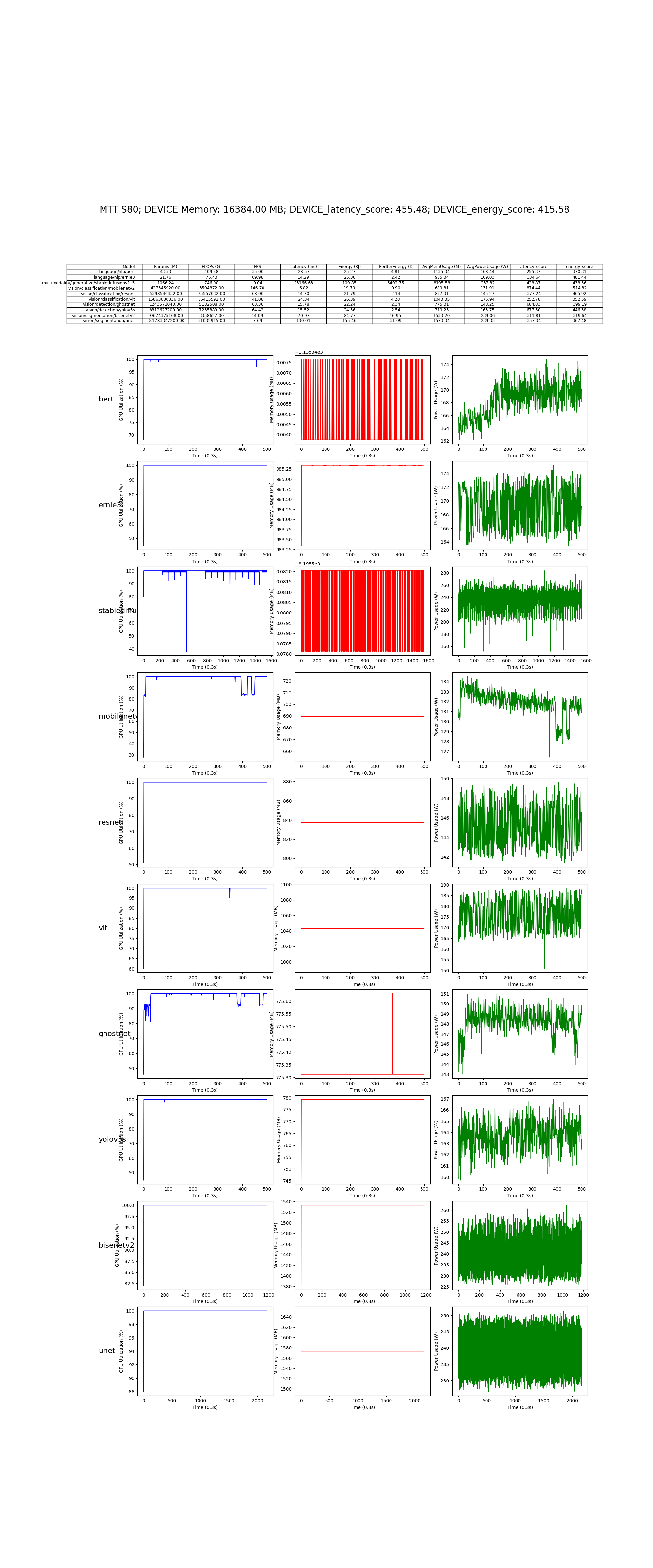

框架模型层

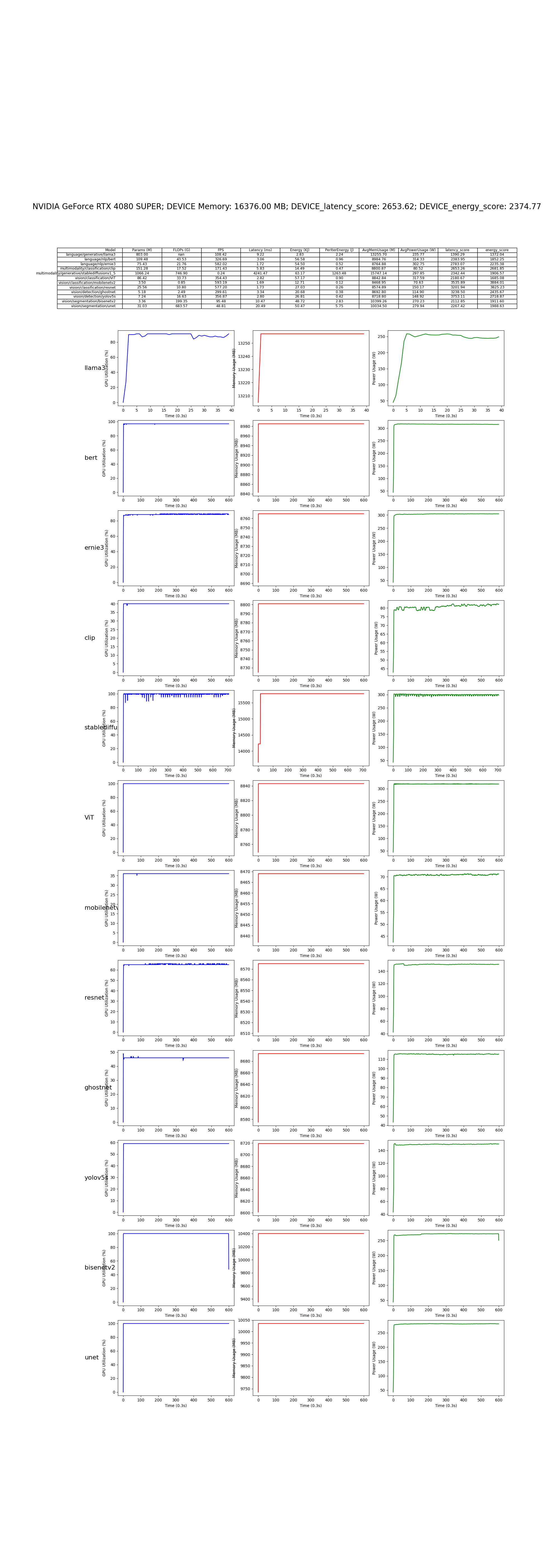

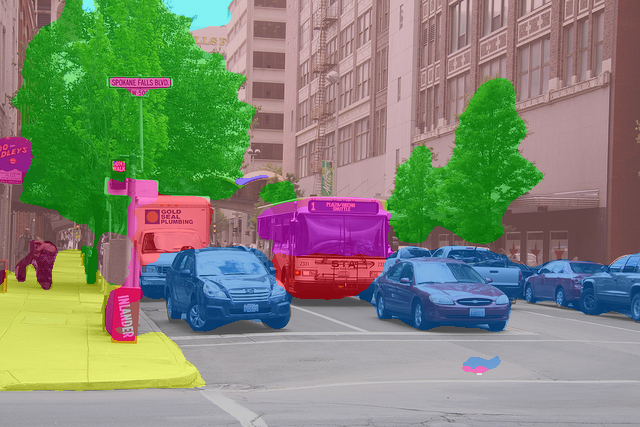

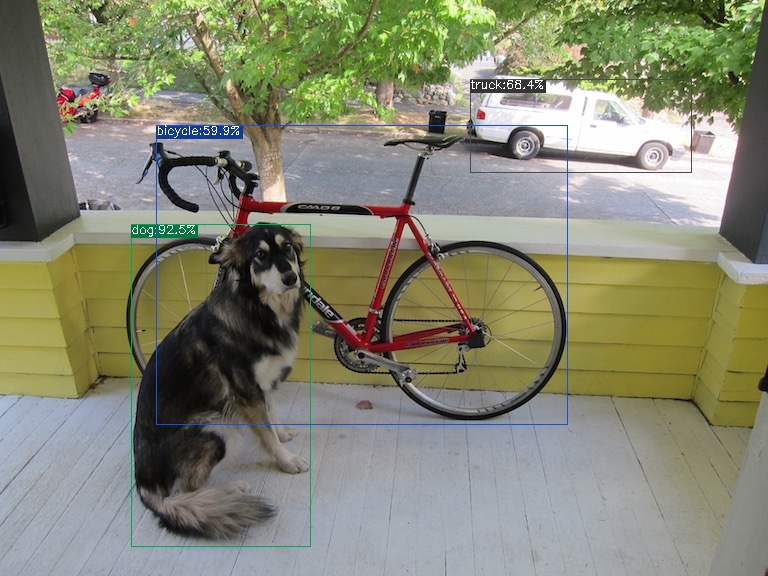

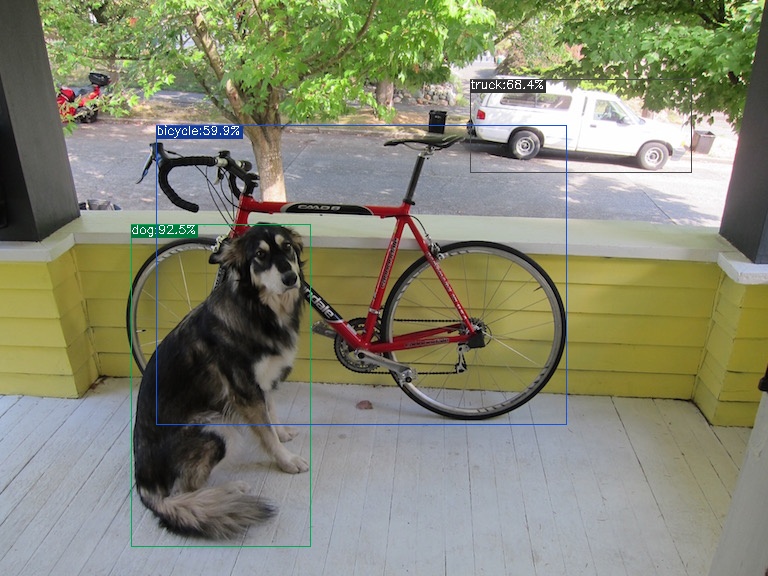

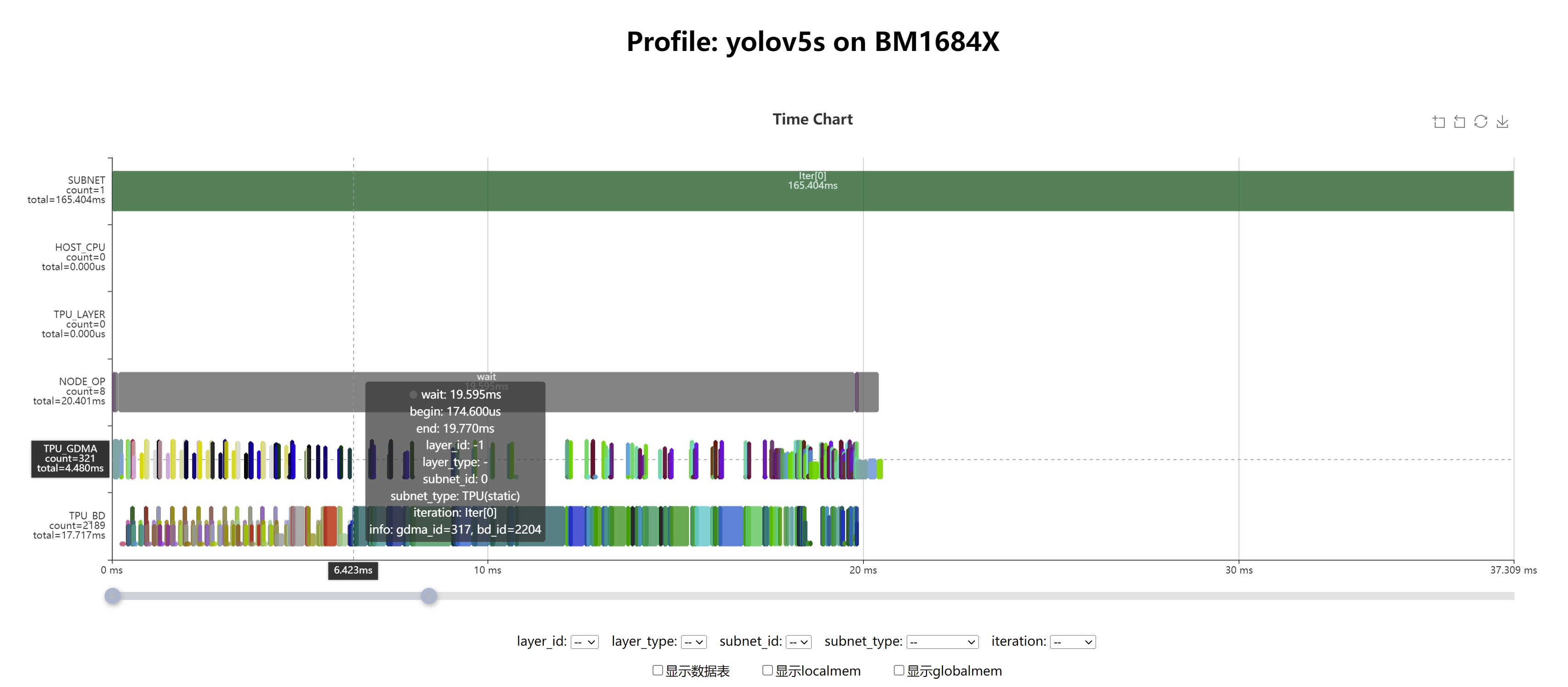

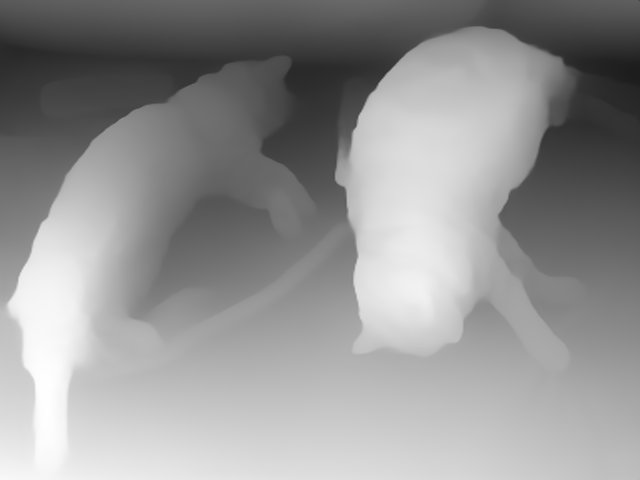

使用基于 PyTorch 的经典深度学习模型集合在 CUDA 平台上对 GPU NVIDIA 进行性能测试

仓库地址:AI-Benchmark-SDU

部分模型代码展示:

LLama3:

'''

Copyright (c) 2024, 山东大学智能创新研究院(Academy of Intelligent Innovation)

Redistribution and use in source and binary forms, with or without

modification, are permitted provided that the following conditions are met:

1. Redistributions of source code must retain the above copyright notice, this

list of conditions and the following disclaimer.

2. Redistributions in binary form must reproduce the above copyright notice,

this list of conditions and the following disclaimer in the documentation

and/or other materials provided with the distribution.

'''

# Copyright (c) Academy of Intelligent Innovation.

# License-Identifier: BSD 2-Clause License

# AI Benchmark SDU Team

from model.model_set.model_base import BaseModel

from llama_cpp import Llama

class llama3_nvidia_amd(BaseModel):

def __init__(self):

super().__init__('language/generative/llama3')

def get_input(self):

self.input = "Q: Name the planets in the solar system? A: "

def load_model(self):

self.llm = Llama(

model_path="model/model_set/pytorch/language/generative/llama3/ggml-meta-llama-3-8b-Q4_K_M.gguf",

n_gpu_layers=99,

# n_gpu_layers=-1, # Uncomment to use GPU acceleration

chat_format="llama-3",

seed=1337, # Uncomment to set a specific seed

n_ctx=2048, # Uncomment to increase the context window

verbose=False

)

def get_params_flops(self) -> list:

return [803, float('nan')]

def inference(self):

output = self.llm (

prompt = self.input, # Prompt

max_tokens=512, # Generate up to 32 tokens, set to None to generate up to the end of the context window

stop=["Q:", "\n"], # Stop generating just before the model would generate a new question

echo=True # Echo the prompt back in the output

)

completion_tokens = output['usage']['completion_tokens']

return completion_tokens

CLIP:

'''

Copyright (c) 2024, 山东大学智能创新研究院(Academy of Intelligent Innovation)

Redistribution and use in source and binary forms, with or without

modification, are permitted provided that the following conditions are met:

1. Redistributions of source code must retain the above copyright notice, this

list of conditions and the following disclaimer.

2. Redistributions in binary form must reproduce the above copyright notice,

this list of conditions and the following disclaimer in the documentation

and/or other materials provided with the distribution.

'''

# Copyright (c) Academy of Intelligent Innovation.

# License-Identifier: BSD 2-Clause License

# AI Benchmark SDU Team

import torch

from model.model_set.model_base import BaseModel

from model.model_set.models.multimodality.classification.clip.utils.model import build_model

from model.model_set.models.multimodality.classification.clip.utils.simpletokenizer import SimpleTokenizer as _Tokenizer

from thop import profile

class clip_nvidia_amd(BaseModel):

def __init__(self):

super().__init__('multimodality/classification/clip')

self.text = ["a diagram", "a dog", "a cat"]

self.input_shape =(1, 3, 224, 224)

self.device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

self.model_path = "model/model_set/pytorch/multimodality/classification/clip/ViT-B-32.pt"

def get_input(self):

self.img = torch.randn(self.input_shape).to(torch.float32).to(self.device)

_tokenizer = _Tokenizer()

sot_token = _tokenizer.encoder["<|startoftext|>"]

eot_token = _tokenizer.encoder["<|endoftext|>"]

all_tokens = [[sot_token] + _tokenizer.encode(text) + [eot_token] for text in self.text]

context_length: int = 77

truncate = False

result = torch.zeros(len(all_tokens), context_length, dtype=torch.int)

for i, tokens in enumerate(all_tokens):

if len(tokens) > context_length:

if truncate:

tokens = tokens[:context_length]

tokens[-1] = eot_token

else:

raise RuntimeError(f"Input {self.text[i]} is too long for context length {context_length}")

result[i, :len(tokens)] = torch.tensor(tokens)

self.texts = result.to(self.device)

def load_model(self):

jit = False

model = torch.jit.load(self.model_path, map_location=self.device if jit else "cpu").eval()

state_dict = None

self.model = build_model(state_dict or model.state_dict()).to(self.device)

def get_params_flops(self) -> list:

flops, _ = profile(self.model, (self.img, self.texts), verbose=False)

params = sum(p.numel() for p in self.model.parameters() if p.requires_grad)

return [flops / 1e9 * 2, params / 1e6]

def inference(self):

image_features = self.model.encode_image(self.img)

text_features = self.model.encode_text(self.texts)

return image_features, text_features

在 NVIDIA GeForce RTX 4080 SUPER 上的测试结果:

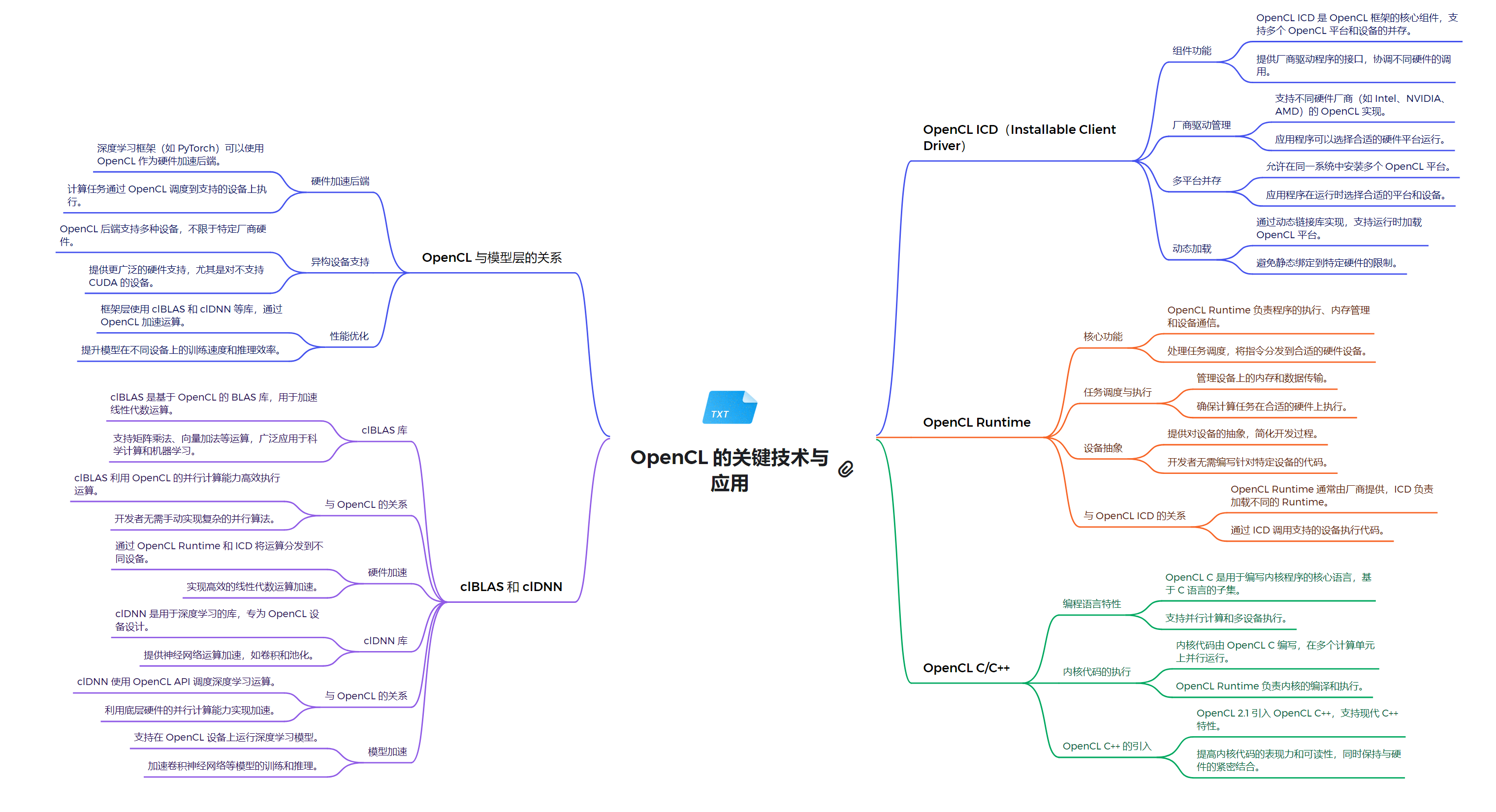

OpenCL (NVIDIA)

OpenCL(Open Computing Language)是一个开放的、跨平台的并行计算框架。虽然NVIDIA主要推广其专有的CUDA平台,但它也支持OpenCL,为开发者提供了更多的灵活性和选择。

OpenCL 概述

-

开放标准:OpenCL由Khronos Group维护,是一个开放的行业标准。

-

跨平台:支持多种硬件,包括CPU、GPU、FPGA等。

-

异构计算:允许在不同类型的处理器上执行计算任务。

OpenCL 在 NVIDIA 平台上的特点

-

兼容性:NVIDIA的GPU驱动程序包含OpenCL实现,使得OpenCL程序可以在NVIDIA GPU上运行。

-

性能:虽然CUDA在NVIDIA硬件上可能提供更优化的性能,但OpenCL也能在NVIDIA GPU上实现高效的并行计算。

-

可移植性:使用OpenCL编写的程序可以在NVIDIA GPU以及其他厂商的硬件上运行,提供了更好的代码可移植性。

-

与CUDA的关系:OpenCL可以看作是CUDA的一个更通用的替代品,但在NVIDIA硬件上可能无法完全发挥其全部潜力。

OpenCL 架构

-

平台模型:包括一个主机和一个或多个OpenCL设备。

-

执行模型:

- 内核(Kernels):在OpenCL设备上执行的函数。

- 工作项(Work-items):内核的单个执行实例。

- 工作组(Work-groups):工作项的集合。

-

内存模型:定义了全局内存、常量内存、局部内存和私有内存。

-

编程模型:支持数据并行和任务并行。

OpenCL vs CUDA on NVIDIA

-

性能:CUDA通常在NVIDIA硬件上提供更好的性能,因为它是专门为NVIDIA GPU优化的。

-

开发工具:NVIDIA为CUDA提供更全面的开发工具和库支持。

-

学习曲线:OpenCL可能有更陡峭的学习曲线,因为它需要处理更多的硬件抽象。

-

市场份额:在NVIDIA生态系统中,CUDA更为普及。

虽然NVIDIA主要推广CUDA,但其对OpenCL的支持为开发者提供了另一种选择。OpenCL在NVIDIA平台上提供了良好的性能和跨平台兼容性,特别适合那些需要在多种硬件平台上运行的应用程序。然而,对于专门针对NVIDIA硬件优化的应用,CUDA可能是更好的选择。选择使用OpenCL还是CUDA取决于具体的项目需求、目标硬件平台和开发团队的专业知识。

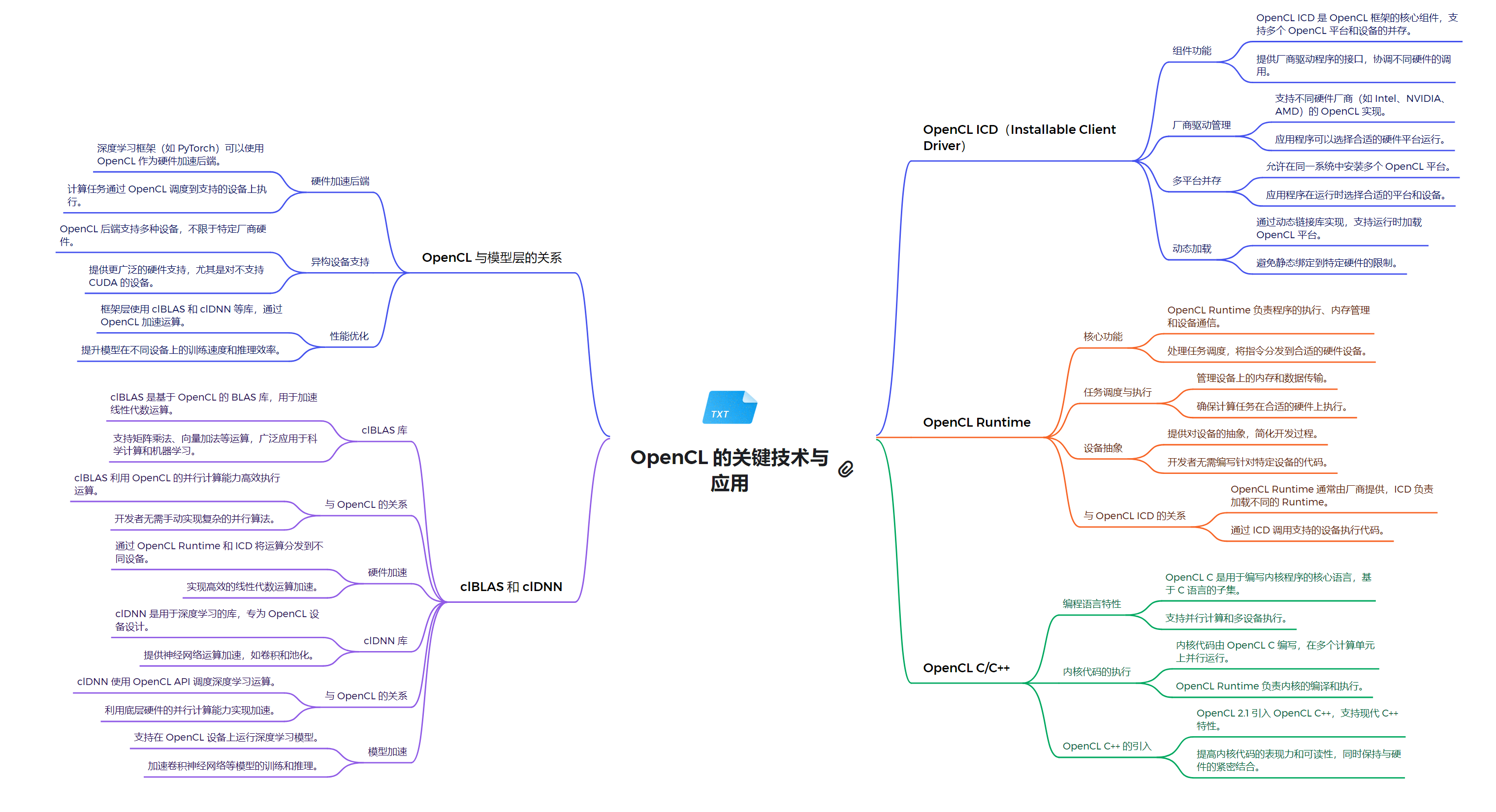

技术栈架构

1. 系统软件层

- 设备驱动程序:

- 为特定硬件(如 GPU、CPU、FPGA)提供底层支持

- 实现 OpenCL 规范定义的功能

- 处理设备特定的优化和功能

- OpenCL ICD (Installable Client Driver):

- 提供对多个 OpenCL 实现的支持

- 允许在同一系统上共存多个 OpenCL 供应商的实现

- 管理不同 OpenCL 实现之间的切换和交互

2. 运行时环境层

- OpenCL Runtime:

- 提供 OpenCL API 的实现

- 管理设备、上下文、命令队列和内存对象

- 处理内核编译和执行

- 协调主机和设备之间的数据传输

- 支持事件和同步机制

3. 编程模型和语言层

- OpenCL C/C++:

- 基于 C99 标准的编程语言,用于编写 OpenCL 内核

- 支持向量数据类型和内置函数

- 提供内存模型和同步原语

- 允许编写可在各种设备上执行的并行代码

- OpenCL C++ 包装器:

- 为 C++ 程序员提供面向对象的 API

- 简化内存管理和错误处理

- 提供更现代的 C++ 接口

4. 计算库层

- clBLAS:

- OpenCL 实现的基本线性代数子程序(BLAS)库

- 提供矩阵和向量操作的高性能实现

- 支持多种设备类型

- clDNN (Compute Library for Deep Neural Networks):

- 用于深度学习的 OpenCL 加速库

- 提供常见的神经网络层和操作

- 优化for各种硬件平台

5. 框架模型层

- TensorFlow with OpenCL:

- 通过 ComputeCpp 或其他 OpenCL 后端支持 OpenCL

- 允许在支持 OpenCL 的设备上运行 TensorFlow 模型

- Caffe with OpenCL:

- 使用 OpenCL 后端的 Caffe 深度学习框架

- 支持在各种 OpenCL 设备上训练和推理

- OpenCV with OpenCL:

- 计算机视觉库,集成了 OpenCL 支持

- 利用 OpenCL 加速图像和视频处理操作

- ArrayFire:

- 高性能计算库,支持 OpenCL 后端

- 提供线性代数、信号处理和计算机视觉功能

- 简化了 OpenCL 编程,提供高级抽象

关系解析

OpenCL作为一个开放的异构计算框架,在模型层面支持硬件加速、跨设备兼容性和性能优化。它的核心组件包括OpenCL ICD、OpenCL Runtime和OpenCL C/C++语言。

OpenCL ICD (Installable Client Driver) 是一个关键组件,它允许多个OpenCL实现共存,提供了一个统一的接口来管理不同厂商的OpenCL实现。这种设计极大地增强了OpenCL的灵活性和可扩展性,使得开发者可以在不同的硬件平台上无缝切换。OpenCL Runtime负责管理设备、内存和任务调度等核心功能。它处理内存分配、数据传输、内核编译和执行等底层操作,为开发者提供了一个抽象层,简化了异构计算的复杂性。Runtime与ICD紧密协作,确保了OpenCL应用程序的高效运行。

在编程语言方面,OpenCL C/C++扩展了标准C/C++,增加了并行计算所需的特性。它支持向量数据类型、内存模型和并行编程构造,使得开发者能够充分利用异构计算资源。OpenCL 2.1引入了SPIR-V中间表示,进一步增强了跨平台兼容性和编译优化。clBLAS和clDNN是基于OpenCL的重要库,分别针对基础线性代数子程序和深度神经网络计算进行了优化。这些库充分利用了OpenCL的并行计算能力,为科学计算和机器学习应用提供了高性能解决方案。OpenCL与其他技术的集成也是其强大之处。例如,深度学习框架如PyTorch可以利用OpenCL进行GPU加速,而OpenCL本身也支持与CUDA等其他并行计算框架的互操作。

总的来说,OpenCL通过其灵活的架构、强大的运行时系统和丰富的编程接口,为异构计算提供了一个全面的解决方案。它不仅支持跨平台开发,还能够充分发挥各种计算设备的性能潜力,在高性能计算、图像处理、科学模拟等领域发挥着重要作用。OpenCL的生态系统持续发展,不断适应新的硬件架构和计算需求,为未来的并行计算和异构系统开发铺平了道路。

系统软件层

该程序使用OpenCL API 列出了系统中所有可用的 NVIDIA 设备,包括设备名称、驱动版本、计算单元数量和全局内存大小,并创建和销毁了一个OpenCL上下文。

-

获取OpenCL平台:使用

clGetPlatformIDs获取系统中的所有 OpenCL 平台。 -

检查NVIDIA平台:遍历平台列表,使用

clGetPlatformInfo检查是否为 NVIDIA 平台。 -

获取设备信息:通过

clGetDeviceIDs获取 NVIDIA 平台中的所有设备,并使用clGetDeviceInfo获取每个设备的详细信息,如设备名称、驱动版本和全局内存大小。 -

创建和销毁上下文:使用

clCreateContext创建一个 OpenCL 上下文,并在使用后释放该上下文。示例代码:

#include <iostream>

#include <cuda.h>

// Check the return value of CUDA functions and print error message on failure

void checkCudaErrors(CUresult result) {

if (result != CUDA_SUCCESS) {

const char *errorStr;

cuGetErrorString(result, &errorStr);

std::cerr << "CUDA Error: " << errorStr << std::endl;

exit(EXIT_FAILURE);

}

}

// Print information about a CUDA device

void printDeviceInfo(CUdevice device) {

int driverVersion = 0;

char deviceName[256];

// Get device name

checkCudaErrors(cuDeviceGetName(deviceName, sizeof(deviceName), device));

int computeCapabilityMajor, computeCapabilityMinor;

// Get the major and minor version of compute capability

checkCudaErrors(cuDeviceGetAttribute(&computeCapabilityMajor, CU_DEVICE_ATTRIBUTE_COMPUTE_CAPABILITY_MAJOR, device));

checkCudaErrors(cuDeviceGetAttribute(&computeCapabilityMinor, CU_DEVICE_ATTRIBUTE_COMPUTE_CAPABILITY_MINOR, device));

size_t totalGlobalMem;

checkCudaErrors(cuDeviceTotalMem(&totalGlobalMem, device));

checkCudaErrors(cuDriverGetVersion(&driverVersion));

// Print device details

std::cout << "Device Name: " << deviceName << std::endl;

std::cout << "Compute Capability: " << computeCapabilityMajor << "." << computeCapabilityMinor << std::endl;

std::cout << "CUDA Driver Version: " << driverVersion / 1000 << "." << (driverVersion % 100) / 10 << std::endl;

std::cout << "Total Global Memory: " << totalGlobalMem / (1024 * 1024) << " MB" << std::endl;

}

int main() {

// Initialize CUDA

checkCudaErrors(cuInit(0));

// Get the number of available CUDA devices

int deviceCount;

checkCudaErrors(cuDeviceGetCount(&deviceCount));

std::cout << "Number of CUDA Devices: " << deviceCount << std::endl;

CUdevice device;

// Iterate through each device and print its information

for (int i = 0; i < deviceCount; i++) {

checkCudaErrors(cuDeviceGet(&device, i));

printDeviceInfo(device);

std::cout << std::endl;

}

CUcontext context;

// Create a CUDA context and set it as the current context

checkCudaErrors(cuCtxCreate(&context, 0, deviceCount > 0 ? device : 0));

checkCudaErrors(cuCtxSetCurrent(context));

std::cout << "CUDA context created successfully." << std::endl;

checkCudaErrors(cuCtxDestroy(context));

return 0;

}

结果:

Platform Name: NVIDIA CUDA

Device Name: NVIDIA GeForce RTX 4080 SUPER

Driver Version: 550.107.02

Max Compute Units: 80

Global Memory Size: 16072 MB

OpenCL context created successfully.

运行时环境层

OpenCL Runtime 是一个软件组件,负责在不同平台和硬件设备上执行 OpenCL 程序。它提供了一系列 API 和工具,帮助开发者管理计算设备、创建和编译 OpenCL 程序、调度任务以及进行内存管理。

设备管理:负责发现和管理可用的计算设备(如 CPU、GPU、FPGA 等),并提供接口以查询设备属性;

上下文创建:用于创建和管理 OpenCL 上下文,上下文包含了设备、内存对象、命令队列和程序;

内存管理:提供内存分配和管理功能,包括在设备上分配和释放内存,支持主机与设备之间的数据传输;

程序编译与执行:支持从源代码创建程序对象,并编译为设备可执行的代码。同时负责调度和执行内核;

命令队列管理:提供命令队列的创建和管理功能,允许用户异步地提交计算任务;

事件和同步:处理事件和同步机制,以确保内核和数据传输的正确顺序执行;

代码示例如下:

#define CL_TARGET_OPENCL_VERSION 220

#include <CL/cl.h>

#include <stdio.h>

#include <stdlib.h>

#include <cstring>

#define ARRAY_SIZE 1024

// OpenCL kernel code for vector addition

const char* kernelSource = "__kernel void vec_add(__global float* A, __global float* B, __global float* C) { \

int id = get_global_id(0); \

C[id] = A[id] + B[id]; \

}";

int main() {

cl_platform_id platform_id;

cl_device_id device_id;

cl_context context;

cl_command_queue queue;

cl_program program;

cl_kernel kernel;

cl_int ret;

// Arrays on the host

float A[ARRAY_SIZE], B[ARRAY_SIZE], C[ARRAY_SIZE];

for (int i = 0; i < ARRAY_SIZE; i++) {

A[i] = i;

B[i] = i * 2;

}

// 1. Get the number of platforms

cl_uint num_platforms;

ret = clGetPlatformIDs(0, NULL, &num_platforms);

if (ret != CL_SUCCESS) {

printf("Failed to get platform IDs\n");

return -1;

}

cl_platform_id* platforms = (cl_platform_id*)malloc(num_platforms * sizeof(cl_platform_id));

ret = clGetPlatformIDs(num_platforms, platforms, NULL);

if (ret != CL_SUCCESS) {

printf("Failed to get platforms\n");

free(platforms);

return -1;

}

// Try to find the NVIDIA platform

for (cl_uint i = 0; i < num_platforms; i++) {

char platform_name[128];

clGetPlatformInfo(platforms[i], CL_PLATFORM_NAME, sizeof(platform_name), platform_name, NULL);

printf("Platform %d: %s\n", i, platform_name);

if (strstr(platform_name, "NVIDIA") != NULL) {

platform_id = platforms[i];

printf("Selected NVIDIA platform: %s\n", platform_name);

break;

}

}

if (!platform_id) {

printf("NVIDIA platform not found\n");

free(platforms);

return -1;

}

// 2. Get the GPU device from the selected NVIDIA platform

ret = clGetDeviceIDs(platform_id, CL_DEVICE_TYPE_GPU, 1, &device_id, NULL);

if (ret != CL_SUCCESS) {

printf("Failed to get GPU device ID from NVIDIA platform, error code: %d\n", ret);

free(platforms);

return -1;

}

// Print the selected device

char device_name[128];

clGetDeviceInfo(device_id, CL_DEVICE_NAME, sizeof(device_name), device_name, NULL);

printf("Selected device: %s\n", device_name);

// 3. Create a context

context = clCreateContext(NULL, 1, &device_id, NULL, NULL, &ret);

if (ret != CL_SUCCESS) {

printf("Failed to create context\n");

free(platforms);

return -1;

}

printf("Context created successfully.\n");

// 4. Create a command queue

queue = clCreateCommandQueueWithProperties(context, device_id, 0, &ret);

if (ret != CL_SUCCESS) {

printf("Failed to create command queue\n");

free(platforms);

return -1;

}

printf("Command queue created successfully.\n");

// 5. Create a program from the kernel source

program = clCreateProgramWithSource(context, 1, &kernelSource, NULL, &ret);

if (ret != CL_SUCCESS) {

printf("Failed to create program\n");

free(platforms);

return -1;

}

printf("Program created successfully.\n");

// 6. Build the program

ret = clBuildProgram(program, 1, &device_id, NULL, NULL, NULL);

if (ret != CL_SUCCESS) {

printf("Failed to build program\n");

char log[1024];

clGetProgramBuildInfo(program, device_id, CL_PROGRAM_BUILD_LOG, sizeof(log), log, NULL);

printf("Build log:\n%s\n", log);

free(platforms);

return -1;

}

printf("Program built successfully.\n");

// 7. Create the kernel

kernel = clCreateKernel(program, "vec_add", &ret);

if (ret != CL_SUCCESS) {

printf("Failed to create kernel\n");

free(platforms);

return -1;

}

printf("Kernel created successfully.\n");

// 8. Create buffers for the input and output arrays

cl_mem buffer_A = clCreateBuffer(context, CL_MEM_READ_ONLY, ARRAY_SIZE * sizeof(float), NULL, &ret);

cl_mem buffer_B = clCreateBuffer(context, CL_MEM_READ_ONLY, ARRAY_SIZE * sizeof(float), NULL, &ret);

cl_mem buffer_C = clCreateBuffer(context, CL_MEM_WRITE_ONLY, ARRAY_SIZE * sizeof(float), NULL, &ret);

if (ret != CL_SUCCESS) {

printf("Failed to create buffers\n");

free(platforms);

return -1;

}

printf("Buffers created successfully.\n");

// 9. Copy the input data to the respective memory buffers

ret = clEnqueueWriteBuffer(queue, buffer_A, CL_TRUE, 0, ARRAY_SIZE * sizeof(float), A, 0, NULL, NULL);

ret |= clEnqueueWriteBuffer(queue, buffer_B, CL_TRUE, 0, ARRAY_SIZE * sizeof(float), B, 0, NULL, NULL);

if (ret != CL_SUCCESS) {

printf("Failed to write to buffers\n");

free(platforms);

return -1;

}

printf("Data written to buffers successfully.\n");

// 10. Set the kernel arguments

ret = clSetKernelArg(kernel, 0, sizeof(cl_mem), (void*)&buffer_A);

ret |= clSetKernelArg(kernel, 1, sizeof(cl_mem), (void*)&buffer_B);

ret |= clSetKernelArg(kernel, 2, sizeof(cl_mem), (void*)&buffer_C);

if (ret != CL_SUCCESS) {

printf("Failed to set kernel arguments\n");

free(platforms);

return -1;

}

printf("Kernel arguments set successfully.\n");

// 11. Execute the kernel

size_t global_size = ARRAY_SIZE;

ret = clEnqueueNDRangeKernel(queue, kernel, 1, NULL, &global_size, NULL, 0, NULL, NULL);

if (ret != CL_SUCCESS) {

printf("Failed to enqueue kernel\n");

free(platforms);

return -1;

}

printf("Kernel enqueued successfully.\n");

// 12. Read the output buffer back to the host

ret = clEnqueueReadBuffer(queue, buffer_C, CL_TRUE, 0, ARRAY_SIZE * sizeof(float), C, 0, NULL, NULL);

if (ret != CL_SUCCESS) {

printf("Failed to read from buffer\n");

free(platforms);

return -1;

}

printf("Data read from buffer successfully.\n");

// Output the results

printf("Result:\n");

for (int i = 0; i < 10; i++) {

printf("C[%d] = %f\n", i, C[i]);

}

// 13. Clean up

clReleaseMemObject(buffer_A);

clReleaseMemObject(buffer_B);

clReleaseMemObject(buffer_C);

clReleaseKernel(kernel);

clReleaseProgram(program);

clReleaseCommandQueue(queue);

clReleaseContext(context);

free(platforms);

printf("Resources released successfully.\n");

return 0;

}

结果:

Platform 0: Intel(R) OpenCL

Platform 1: NVIDIA CUDA

Selected NVIDIA platform: NVIDIA CUDA

Selected device: NVIDIA GeForce RTX 4080 SUPER

Context created successfully.

Command queue created successfully.

Program created successfully.

Program built successfully.

Kernel created successfully.

Buffers created successfully.

Data written to buffers successfully.

Kernel arguments set successfully.

Kernel enqueued successfully.

Data read from buffer successfully.

Result:

C[0] = 0.000000

C[1] = 3.000000

C[2] = 6.000000

C[3] = 9.000000

C[4] = 12.000000

C[5] = 15.000000

C[6] = 18.000000

C[7] = 21.000000

C[8] = 24.000000

C[9] = 27.000000

结果说明:

Platform 0: Intel(R) OpenCL

表示系统上检测到一个 OpenCL 平台,提供商是 Intel,可能是用于 CPU 或集成显卡的 OpenCL 运行时;

Platform 1: NVIDIA CUDA

表示另一个 OpenCL 平台由 NVIDIA 提供,基于 CUDA 技术,能够在 NVIDIA GPU 上运行 OpenCL 程序;

Selected NVIDIA platform: NVIDIA CUDA

程序成功选择了 NVIDIA CUDA 平台,以在 NVIDIA GPU 上运行;

Selected device: NVIDIA GeForce RTX 4080 SUPER

选择的设备是 NVIDIA GeForce RTX 4080 SUPER,这是你的 GPU,程序将在此设备上执行计算;

Context created successfully.

成功创建了 OpenCL 上下文(context),它负责管理设备、内核和内存对象的生命周期;

Command queue created successfully.

成功创建了命令队列,程序通过此队列向 GPU 发送计算任务;

Program created successfully.

OpenCL 程序(从字符串中创建)已成功创建。该程序包含内核代码;

Program built successfully.

内核程序已成功编译和构建,没有语法或其他构建错误;

Kernel created successfully.

程序中定义的内核函数 hello 成功创建,可以在设备上运行;

Buffers created successfully.

程序成功为 GPU 分配了缓冲区(内存对象),这些缓冲区将用于存储输入数据和输出结果;

Data written to buffers successfully.

输入数据已经成功写入 GPU 缓冲区,准备进行计算;

Kernel arguments set successfully.

成功将内核函数的参数设置为相应的 GPU 缓冲区;

Kernel enqueued successfully.

内核已被添加到命令队列中,准备在 GPU 上执行;

Data read from buffer successfully.

内核执行完成后,成功从 GPU 缓冲区中读取结果数据;

Result:

C[0] = 0.000000

C[1] = 3.000000

C[2] = 6.000000

C[3] = 9.000000

C[4] = 12.000000

C[5] = 15.000000

C[6] = 18.000000

C[7] = 21.000000

C[8] = 24.000000

C[9] = 27.000000

这是计算结果,可能是一个简单的线性计算,每个输出值是由内核函数计算得到的。此例中,每个结果都以步长 3 递增,从 0 开始;

Resources released successfully.

程序成功释放了所有分配的资源,包括内核、程序、队列、上下文等。

编程模型和语言层

OpenCL 支持在多种设备上进行并行计算,如CPU、GPU、FPGA等。OpenCL 由 Khronos Group 管理,是一种跨平台的并行编程语言,它在不同的硬件架构上提供了统一的编程接口。

1. OpenCL 的核心编程特性

OpenCL 是一个相对底层的 API,与 CUDA 类似,它同样强调对设备内存和计算资源的精确控制。OpenCL的编程模型包含以下关键特性:

- 平台模型 :OpenCL 的平台模型由 主机(host) 和一个或多个 设备(device) 组成。在一个平台上,主机通常是 CPU,设备可以是 GPU 或其他加速器。开发者需要显式地管理主机和设备之间的交互。

- 上下文和命令队列 :OpenCL 引入了上下文(context)来管理设备,程序对象和内存对象的生命周期。命令队列(command queue)用于调度执行内核(kernel)和数据传输操作。每个设备都拥有一个或多个命令队列,支持并行化任务执行。

- 内核(Kernel)函数 :OpenCL 的计算核心是内核函数,它定义了在设备上并行执行的代码。内核函数使用

__kernel修饰符,表明其在设备上执行。内核的执行由全局工作项(global work-items)和局部工作组(local work-groups)组织。

__kernel void vectorAdd(__global const float* A, __global const float* B, __global float* C, int N) {

int i = get_global_id(0);

if (i < N) C[i] = A[i] + B[i];

}

这个简单的内核展示了如何通过OpenCL执行并行向量加法运算,get_global_id(0) 获取当前工作项的唯一ID,用于计算索引。

- 内存模型 :OpenCL 的内存模型包括全局内存(global memory)、常量内存(constant memory)、局部内存(local memory)和私有内存(private memory)。每个工作项可以访问不同级别的内存,这些内存具有不同的性能特性和作用范围。

- 设备和内存管理 :与CUDA类似,OpenCL要求开发者手动管理主机和设备之间的内存传输。通过

clCreateBuffer创建缓冲区对象,并使用clEnqueueWriteBuffer和clEnqueueReadBuffer在主机和设备之间传输数据。

2. 算子编写示例:矩阵乘法

矩阵乘法是并行计算中常见的操作之一,下面展示如何在OpenCL中实现并行矩阵乘法:

__kernel void matrixMul(__global float* A, __global float* B, __global float* C, int N) {

int row = get_global_id(1);

int col = get_global_id(0);

float result = 0.0;

if (row < N && col < N) {

for (int i = 0; i < N; ++i) {

result += A[row * N + i] * B[i * N + col];

}

C[row * N + col] = result;

}

}

该内核函数中,使用 get_global_id(0) 和 get_global_id(1) 分别获取当前工作项在全局工作空间中的横纵坐标(行和列)。每个工作项负责计算结果矩阵中的一个元素,通过访问内存中的数据并进行并行计算实现。

3. 并行计算模型介绍

OpenCL 的并行计算模型与 CUDA 在一些方面类似,但它是一个更加通用的异构计算标准,能够在不同的硬件架构上执行。以下是 OpenCL 并行计算模型的主要概念:

- 工作项(Work-Item)与工作组(Work-Group) :OpenCL 中的并行计算任务被划分为工作项,每个工作项独立执行一小部分计算。多个工作项组成工作组,工作组之间相互独立,工作项可以在同一工作组中共享数据并进行同步操作。

- 全局与局部内存 :工作项可以访问全局内存,但全局内存通常比局部内存慢。因此,合理使用局部内存来减少对全局内存的访问可以极大提升性能。

- 命令队列与同步 :在OpenCL中,主机通过命令队列向设备提交计算任务。OpenCL支持事件机制,允许在任务完成后触发事件。这种机制使得开发者可以更好地控制任务的调度和设备的计算资源。

4. OpenCL 与 CUDA 的对比

虽然 OpenCL 和 CUDA 在设计上有一些相似之处,特别是在内存模型和并行任务调度方面,但它们之间仍然存在显著差异:

- 跨平台性 :CUDA 是 NVIDIA 专有的技术,虽然在 NVIDIA GPU 上表现优异,但只能用于 NVIDIA 硬件。相比之下,OpenCL 是一个跨平台标准,支持在各种硬件上执行,适合需要在多种设备上运行的异构计算场景。

- 生态与性能 :虽然 OpenCL 提供了跨平台的灵活性,但由于其底层抽象程度较高,性能在某些情况下可能不及 CUDA 尤其是在 NVIDIA 硬件上。NVIDIA 对 CUDA 的优化力度更大,提供了许多额外的库支持(如 cuBLAS、cuDNN),而这些库在 OpenCL 上并不可用。

- 编程复杂度 :OpenCL 代码编写通常较为复杂,因为它需要显式管理设备上下文、内存分配、内核调度等。而 CUDA 通过一些简化的工具和库,使得编程过程相对更加简便。

5. OpenCL 在 AI 开发中的应用

尽管 OpenCL 在深度学习和AI开发中的应用不如CUDA广泛,但它在某些特定的场景下仍然具有重要的价值,尤其是那些需要跨平台计算的环境:

- 通用性和兼容性 :对于那些需要在不同硬件平台上运行的AI应用,OpenCL 提供了跨平台的并行计算支持。例如,在一些需要同时支持CPU和AMD、NVIDIA GPU的场景中,OpenCL的兼容性使得它成为理想的选择。

- 嵌入式与低功耗设备 :在边缘计算和嵌入式设备中,OpenCL 因为其广泛的硬件支持,能够在资源有限的环境中提供GPU加速能力。

- 优化深度学习库 :虽然NVIDIA更多推崇CUDA,但像 ARM、AMD 等厂商在其AI硬件上更多依赖OpenCL,推动了在这些平台上对深度学习库(如 TensorFlow Lite 和 ONNX Runtime)的优化。

6. 总结

NVIDIA OpenCL 提供了一套灵活的并行编程模型,适合跨平台的异构计算场景。在 NVIDIA 平台上,尽管 CUDA 是更加成熟的选择,但 OpenCL 作为通用的并行编程标准,依然在一些跨平台应用和异构计算中具有重要地位。通过理解 OpenCL 的编程模型,开发者能够在需要跨设备和跨平台的应用中充分发挥其优势,构建高效的并行计算系统。

计算库层

clBLAS 是一个开源的高性能线性代数库,专为 OpenCL 平台设计,支持多种基本线性代数操作,如矩阵乘法和矩阵-向量乘法。clBLAS 利用 OpenCL 的并行计算能力,提供灵活的内存管理和高效的内核优化,显著提升线性代数运算的性能。

参考仓库地址:clBLAS

clblasChemm 展示了如何使用 clBLAS 进行复数矩阵的乘法操作。

示例代码如下:

/* ************************************************************************

* Copyright 2013 Advanced Micro Devices, Inc.

*

* Licensed under the Apache License, Version 2.0 (the "License");

* you may not use this file except in compliance with the License.

* You may obtain a copy of the License at

*

* http://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

* ************************************************************************/

#include <sys/types.h>

#include <stdio.h>

#include <string.h>

/* Include CLBLAS header. It automatically includes needed OpenCL header,

* so we can drop out explicit inclusion of cl.h header.

*/

#include <clBLAS.h>

/* This example uses predefined matrices and their characteristics for

* simplicity purpose.

*/

static const clblasOrder order = clblasRowMajor;

#define M 4

#define N 3

static const cl_float2 alpha = {{10, 10}};

static const clblasSide side = clblasLeft;

static const clblasUplo uplo = clblasLower;

static const cl_float2 A[M*M] = {

{{11, 12}}, {{-1, -1}}, {{-1, -1}}, {{-1, -1}},

{{21, 22}}, {{22, 23}}, {{-1, -1}}, {{-1, -1}},

{{31, 32}}, {{32, 33}}, {{33, 34}}, {{-1, -1}},

{{41, 61}}, {{42, 62}}, {{43, 73}}, {{44, 23}}

};

static const size_t lda = M;

static const cl_float2 B[M*N] = {

{{11, -21}}, {{-12, 23}}, {{13, 33}},

{{21, 12}}, {{22, -10}}, {{23, 5}},

{{31, 1}}, {{-32, 65}}, {{33, -1}},

{{1, 41}}, {{-33, 42}}, {{12, 43}},

};

static const size_t ldb = N;

static const cl_float2 beta = {{20, 20}};

static cl_float2 C[M*N] = {

{{11, 11}}, {{-12, 12}}, {{13, 33}},

{{21, -32}}, {{22, -1}}, {{23, 0}},

{{31, 13}}, {{-32, 78}}, {{33, 45}},

{{41, 14}}, {{0, 42}}, {{43, -1}},

};

static const size_t ldc = N;

static void

printResult(void)

{

size_t i, j, nrows;

printf("Result:\n");

nrows = (sizeof(C) / sizeof(cl_float2)) / ldc;

for (i = 0; i < nrows; i++) {

for (j = 0; j < ldc; j++) {

printf("<%9.2f, %-9.2f> ", CREAL(C[i * ldc + j]), CIMAG(C[i*ldc + j]));

}

printf("\n");

}

}

int

main(void)

{

cl_int err;

cl_platform_id platform = 0;

cl_device_id device = 0;

cl_context_properties props[3] = { CL_CONTEXT_PLATFORM, 0, 0 };

cl_context ctx = 0;

cl_command_queue queue = 0;

cl_mem bufA, bufB, bufC;

cl_event event = NULL;

int ret = 0;

/* Setup OpenCL environment. */

err = clGetPlatformIDs(1, &platform, NULL);

if (err != CL_SUCCESS) {

printf( "clGetPlatformIDs() failed with %d\n", err );

return 1;

}

err = clGetDeviceIDs(platform, CL_DEVICE_TYPE_GPU, 1, &device, NULL);

if (err != CL_SUCCESS) {

printf( "clGetDeviceIDs() failed with %d\n", err );

return 1;

}

props[1] = (cl_context_properties)platform;

ctx = clCreateContext(props, 1, &device, NULL, NULL, &err);

if (err != CL_SUCCESS) {

printf( "clCreateContext() failed with %d\n", err );

return 1;

}

queue = clCreateCommandQueue(ctx, device, 0, &err);

if (err != CL_SUCCESS) {

printf( "clCreateCommandQueue() failed with %d\n", err );

clReleaseContext(ctx);

return 1;

}

/* Setup clblas. */

err = clblasSetup();

if (err != CL_SUCCESS) {

printf("clblasSetup() failed with %d\n", err);

clReleaseCommandQueue(queue);

clReleaseContext(ctx);

return 1;

}

/* Prepare OpenCL memory objects and place matrices inside them. */

bufA = clCreateBuffer(ctx, CL_MEM_READ_ONLY, M * M * sizeof(*A),

NULL, &err);

bufB = clCreateBuffer(ctx, CL_MEM_READ_ONLY, M * N * sizeof(*B),

NULL, &err);

bufC = clCreateBuffer(ctx, CL_MEM_READ_WRITE, M * N * sizeof(*C),

NULL, &err);

err = clEnqueueWriteBuffer(queue, bufA, CL_TRUE, 0,

M * M * sizeof(*A), A, 0, NULL, NULL);

err = clEnqueueWriteBuffer(queue, bufB, CL_TRUE, 0,

M * N * sizeof(*B), B, 0, NULL, NULL);

err = clEnqueueWriteBuffer(queue, bufC, CL_TRUE, 0,

M * N * sizeof(*C), C, 0, NULL, NULL);

/* Call clblas function. */

err = clblasChemm(order, side, uplo, M, N, alpha, bufA,

0, lda, bufB, 0, ldb, beta, bufC, 0, ldc, 1, &queue,

0, NULL, &event);

if (err != CL_SUCCESS) {

printf("clblasSsymm() failed with %d\n", err);

ret = 1;

}

else {

/* Wait for calculations to be finished. */

err = clWaitForEvents(1, &event);

/* Fetch results of calculations from GPU memory. */

err = clEnqueueReadBuffer(queue, bufC, CL_TRUE, 0, M * N * sizeof(*C),

C, 0, NULL, NULL);

/* At this point you will get the result of SYMM placed in C array. */

printResult();

}

/* Release OpenCL events. */

clReleaseEvent(event);

/* Release OpenCL memory objects. */

clReleaseMemObject(bufC);

clReleaseMemObject(bufB);

clReleaseMemObject(bufA);

/* Finalize work with clblas. */

clblasTeardown();

/* Release OpenCL working objects. */

clReleaseCommandQueue(queue);

clReleaseContext(ctx);

return ret;

}

结果:

Result:

< 41430.00, 46230.00 > <-39740.00, 87400.00 > < 48960.00, 48400.00 >

< 41360.00, 54760.00 > <-48340.00, 90520.00 > < 32620.00, 53220.00 >

< 28830.00, 79370.00 > <-67980.00, 77040.00 > < 13400.00, 81160.00 >

<-24980.00, 90100.00 > <-114700.00, -43780.00> <-67560.00, 93200.00 >

clblasScopy 是 clBLAS 库中的一个函数,它是 BLAS 标准中 scopy 函数的 OpenCL 版本。scopy 函数的作用是复制浮点数组。在 clBLAS 中,clblasScopy 用于将一个浮点数组复制到另一个浮点数组,这两个数组可以位于不同的内存区域。

示例代码如下:

/* ************************************************************************

* Copyright 2013 Advanced Micro Devices, Inc.

*

* Licensed under the Apache License, Version 2.0 (the "License");

* you may not use this file except in compliance with the License.

* You may obtain a copy of the License at

*

* http://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

* ************************************************************************/

#include <sys/types.h>

#include <stdio.h>

#include <string.h>

#include <math.h>

/* Include CLBLAS header. It automatically includes needed OpenCL header,

* so we can drop out explicit inclusion of cl.h header.

*/

#include <clBLAS.h>

/* This example uses predefined matrices and their characteristics for

* simplicity purpose.

*/

static const size_t N = 7;

static cl_float X[] = {

11,

21,

31,

41,

51,

61,

71,

};

static const int incx = 1;

static cl_float Y[] = {

0,

2,

0,

0,

0,

5,

0,

};

static const int incy = 1;

static void

printResult(void)

{

size_t i;

printf("\nResult:\n");

printf(" X\n");

for (i = 0; i < N; i++) {

printf("\t%f\n", X[i]);

}

printf("Y\n");

for (i = 0; i < N; i++) {

printf("\t%f\n", Y[i]);

}

}

int

main(void)

{

cl_int err;

cl_platform_id platform = 0;

cl_device_id device = 0;

cl_context_properties props[3] = { CL_CONTEXT_PLATFORM, 0, 0 };

cl_context ctx = 0;

cl_command_queue queue = 0;

cl_mem bufX, bufY;

cl_event event = NULL;

int ret = 0;

int lenX = 1 + (N-1)*abs(incx);

int lenY = 1 + (N-1)*abs(incy);

/* Setup OpenCL environment. */

err = clGetPlatformIDs(1, &platform, NULL);

if (err != CL_SUCCESS) {

printf( "clGetPlatformIDs() failed with %d\n", err );

return 1;

}

err = clGetDeviceIDs(platform, CL_DEVICE_TYPE_GPU, 1, &device, NULL);

if (err != CL_SUCCESS) {

printf( "clGetDeviceIDs() failed with %d\n", err );

return 1;

}

props[1] = (cl_context_properties)platform;

ctx = clCreateContext(props, 1, &device, NULL, NULL, &err);

if (err != CL_SUCCESS) {

printf( "clCreateContext() failed with %d\n", err );

return 1;

}

queue = clCreateCommandQueue(ctx, device, 0, &err);

if (err != CL_SUCCESS) {

printf( "clCreateCommandQueue() failed with %d\n", err );

clReleaseContext(ctx);

return 1;

}

/* Setup clblas. */

err = clblasSetup();

if (err != CL_SUCCESS) {

printf("clblasSetup() failed with %d\n", err);

clReleaseCommandQueue(queue);

clReleaseContext(ctx);

return 1;

}

/* Prepare OpenCL memory objects and place matrices inside them. */

bufX = clCreateBuffer(ctx, CL_MEM_READ_ONLY, (lenX*sizeof(cl_float)), NULL, &err);

bufY = clCreateBuffer(ctx, CL_MEM_READ_WRITE, (lenY*sizeof(cl_float)), NULL, &err);

err = clEnqueueWriteBuffer(queue, bufX, CL_TRUE, 0, (lenX*sizeof(cl_float)), X, 0, NULL, NULL);

err = clEnqueueWriteBuffer(queue, bufY, CL_TRUE, 0, (lenY*sizeof(cl_float)), Y, 0, NULL, NULL);

/* Call clblas function. */

err = clblasScopy( N, bufX, 0, incx, bufY, 0, incy, 1, &queue, 0, NULL, &event);

if (err != CL_SUCCESS) {

printf("clblasScopy() failed with %d\n", err);

ret = 1;

}

else {

/* Wait for calculations to be finished. */

err = clWaitForEvents(1, &event);

/* Fetch results of calculations from GPU memory. */

err = clEnqueueReadBuffer(queue, bufX, CL_TRUE, 0, (lenX*sizeof(cl_float)),

X, 0, NULL, NULL);

err = clEnqueueReadBuffer(queue, bufY, CL_TRUE, 0, (lenY*sizeof(cl_float)),

Y, 0, NULL, NULL);

/* At this point you will get the result of SSWAP placed in vector Y. */

printResult();

}

/* Release OpenCL events. */

clReleaseEvent(event);

/* Release OpenCL memory objects. */

clReleaseMemObject(bufY);

clReleaseMemObject(bufX);

/* Finalize work with clblas. */

clblasTeardown();

/* Release OpenCL working objects. */

clReleaseCommandQueue(queue);

clReleaseContext(ctx);

return ret;

}

结果:

Result:

X

11.000000

21.000000

31.000000

41.000000

51.000000

61.000000

71.000000

Y

11.000000

21.000000

31.000000

41.000000

51.000000

61.000000

71.000000

clblasSgemm 是 clBLAS 库中的一个函数,用于执行单精度浮点数的矩阵乘法。Sgemm 代表单精度(Single precision)和矩阵乘法(GEneral Matrix-Matrix multiplication)。这个函数是 BLAS 库中最基本的函数之一,广泛用于科学计算、工程模拟、数据分析和机器学习等领域。

示例代码如下:

#include <stdio.h>

#include <stdlib.h>

#include <CL/cl.h>

#include <clBLAS.h>

#include <sys/time.h>

#define M 320

#define N 320

#define K 320

#define ITERATIONS 300

static const clblasOrder order = clblasRowMajor;

static const cl_float alpha = 1.0f;

static const clblasTranspose transA = clblasNoTrans;

static const clblasTranspose transB = clblasNoTrans;

static const cl_float beta = 0.0f;

static cl_float A[M*K];

static cl_float B[K*N];

static cl_float C[M*N];

static cl_float result[M*N];

void initMatrix(cl_float *mat, size_t size, cl_float value) {

for (size_t i = 0; i < size; i++) {

mat[i] = value;

}

}

double getCurrentTimeInMilliseconds() {

struct timeval time;

gettimeofday(&time, NULL);

return time.tv_sec * 1000.0 + time.tv_usec / 1000.0;

}

int main(void) {

cl_int err;

cl_platform_id platform = 0;

cl_device_id device = 0;

cl_context_properties props[3] = { CL_CONTEXT_PLATFORM, 0, 0 };

cl_context ctx = 0;

cl_command_queue queue = 0;

cl_mem bufA, bufB, bufC;

cl_event event = NULL;

printf("[Matrix Multiply Using clBLAS] - Starting...\n");

// Initialize matrices

initMatrix(A, M * K, 1.0f);

initMatrix(B, K * N, 0.01f);

initMatrix(C, M * N, 0.0f);

// Setup OpenCL environment

err = clGetPlatformIDs(1, &platform, NULL);

err = clGetDeviceIDs(platform, CL_DEVICE_TYPE_GPU, 1, &device, NULL);

// Create OpenCL context and command queue

props[1] = (cl_context_properties)platform;

ctx = clCreateContext(props, 1, &device, NULL, NULL, &err);

queue = clCreateCommandQueue(ctx, device, 0, &err);

// Setup clBLAS

clblasSetup();

// Prepare OpenCL memory objects

bufA = clCreateBuffer(ctx, CL_MEM_READ_ONLY, M * K * sizeof(*A), NULL, &err);

bufB = clCreateBuffer(ctx, CL_MEM_READ_ONLY, K * N * sizeof(*B), NULL, &err);

bufC = clCreateBuffer(ctx, CL_MEM_READ_WRITE, M * N * sizeof(*C), NULL, &err);

clEnqueueWriteBuffer(queue, bufA, CL_TRUE, 0, M * K * sizeof(*A), A, 0, NULL, NULL);

clEnqueueWriteBuffer(queue, bufB, CL_TRUE, 0, K * N * sizeof(*B), B, 0, NULL, NULL);